Sora iOS SDK ドキュメント¶

このドキュメントは Sora iOS SDK バージョン 2026.1.0 に対応しています。

Sora 自体の製品お問い合わせは sora at shiguredo dot jp までお願い致します。 (このメールアドレスへの特定電子メールの送信を拒否いたします)

問い合わせについて¶

Sora iOS SDK の質問などについては Discord の #sora-sdk-faq をご利用ください。

ただし、 Sora のライセンス契約の有無に関わらず、応答時間と問題の解決を保証しませんのでご了承ください。

Sora iOS SDK に対する有償のサポートについては提供しておりません。

重要なお知らせ¶

CocoaPods での提供終了について¶

注釈

Sora iOS SDK は 2025.1.x 系のリリースを最後に CocoaPods での提供を終了し、 今後は Swift Package Manager での提供のみになります。 2025 年中のリリースについてはご要望いただければ CocoaPods 対応版を提供しますので、「問い合わせについて」 を参照し、ご連絡ください。

重要

2026 年以降の CocoaPods 対応については優先実装での対応になります。

CocoaPods のブログで CocoaPods がメンテナンスモードであることと、CocoaPods Trunk が 2026 年 12 月 2 日に読み取り専用になることが発表されました。

元々、Sora iOS SDK は CocoaPods Trunk を利用していませんが上の発表を受けて、CocoaPods での SDK 提供を終了することにしました。

今後は Swift Package Manager 経由で SDK をインストールすることを推奨します。

2025.2.0 にて connect メッセージの multistream を true 固定で送信する仕様を廃止しました¶

2025.2.0 にて connect メッセージの multistream を true 固定で送信する仕様を廃止しました。

Sora でレガシーストリームを有効に設定しているかつマルチストリーム機能を利用している場合、実装によっては接続が失敗するケースがあります。

移行が必要な条件や、移行方法について 2025.1.x から 2025.2.x への移行 を参照して対応をお願いします。

2023.3.0 にて利用不可項目の削除を行いました¶

2023.3.0 にて廃止、廃止予定項目の削除を行いました。

対象の項目を利用していた場合、ビルドエラーが発生します。 移行作業が必要となるため 利用不可項目の削除について を参照して対応をお願いします。

Sora iOS SDK 概要¶

Sora iOS SDK は 株式会社時雨堂 の「 WebRTC SFU Sora 」の iOS 専用クライアントフレームワークです。 WebRTC の複雑な接続処理を肩代わりする API を提供し、 Sora を利用する iOS アプリケーションを最小限のソースコードで実装できます。

主な仕様¶

Sora との接続¶

Sora と接続してメディアチャネルの通信を確立します。

メディアデータの再生¶

Sora との間に送受信されるメディアデータ (映像と音声) を描画・再生する UI コンポーネントを提供します。

カメラとマイクの自動的な初期化¶

メディアチャネルの通信が確立すると iOS 端末のカメラとマイクが初期化され、カメラとマイクからの入力を Sora に送信できるようになります。

非対応の機能¶

次の機能は非対応です。 現在対応する予定はありません。

Objective-C API: Sora iOS SDK は Swift にのみ対応します。

ソースコード¶

サンプルソースコード¶

問い合わせについて¶

Sora iOS SDK の質問などについては Discord の #sora-sdk-faq チャンネルにお願いします。

ただし、 Sora のライセンス契約の有無に関わらず、応答時間と問題の解決を保証しませんのでご了承ください。

Sora iOS SDK に対する有償のサポートについては提供しておりません。

リリースノート¶

- CHANGE

後方互換性のない変更

- UPDATE

後方互換性がある変更

- ADD

後方互換性がある追加

- FIX

バグ修正

2026.1.0¶

- 日付:

2026-02-20

- 対応 Sora:

2025.2.0 以降

- 対応 iOS:

14.0 以降

- 対応 libwebrtc:

m144.7559.2.2

ハイライト¶

音声と映像のミュート機能を追加しました

詳細は ミュート機能 をご確認ください

音声データを音声トラックごとにコールバックで受け取るためのインターフェースである

RTCAudioTrackSinkを追加しました詳細は 受信した音声データを取得する をご確認ください

RPC 機能に対応しました

詳細は RPC 機能 をご確認ください

MediaChannelに libwebrtc の統計情報を取得するgetStatsメソッドを追加しました詳細は 統計情報 をご確認ください

非推奨情報¶

Configuration.simulcastRidを非推奨にしました2027 年 12 月リリースの Sora にて、シグナリング接続時の

simulcast_ridが廃止予定であるため非推奨にしました移行先は

Configuration.simulcastRequestRidです

変更履歴¶

[UPDATE] WebRTC m144.7559.2.2 に上げました

[UPDATE]

PeerChannel.initializeAudioInputでの音声入力初期化時にマイク入力をミュートするか設定できるようにしました[UPDATE]

VideoHardMuteActorでの映像ハードミュート解除時に、カメラキャプチャ未起動なら開始するようにしました[UPDATE]

StatisticsとStatisticsEntryを API リファレンスに公開しました[UPDATE]

Configuration.simulcastRidを非推奨にしました移行先は

Configuration.simulcastRequestRidです

[ADD]

Configurationに接続確立時のマイク入力を有効にするか設定できるinitialMicrophoneEnabledを追加しました接続時に音声ハードミュートを行うために利用できます

[ADD]

Configurationに接続確立時にカメラ初期化を行わない設定initialCameraEnabledを追加しました接続時に映像ハードミュートを行うために利用できます

[ADD]

MediaChannelに音声ハードミュートを有効化/無効化するメソッドsetAudioHardMuteを追加しました[ADD]

MediaChannelに音声ソフトミュートを有効化/無効化するメソッドsetAudioSoftMuteを追加しました[ADD]

MediaChannelに映像ハードミュートを有効化/無効化するメソッドsetVideoHardMuteを追加しました[ADD]

MediaChannelに映像ソフトミュートを有効化/無効化するメソッドsetVideoSoftMuteを追加しました[ADD]

MediaChannelに libwebrtc の統計情報を取得するgetStatsメソッドを追加しました[ADD]

RTCAudioTrackから音声データを受け取るためのコールバックプロトコルRTCAudioTrackSinkを追加しました[ADD]

MediaStreamにRTCAudioTrackSinkをRTCAudioTrackと関連付ける / 関連付けを解除するためのメソッドを追加しました関連付けるためのメソッド:

addAudioTrackSink(_ sink: RTCAudioTrackSink)関連付けを解除するためのメソッド:

removeAudioTrackSink(_ sink: RTCAudioTrackSink)

[ADD] シグナリング接続時に視聴するストリームの rid を指定する

Configuration.simulcastRequestRid: SimulcastRequestRidを追加しましたrid を指定できる値の列挙型として

SimulcastRequestRidを追加しましたデフォルト値の

unspecifiedの場合は、シグナリングパラメーターにsimulcast_request_ridを含めませんこの設定は role が sendrecv または recvonly の場合、かつ simulcast が true の場合にのみ有効です

[ADD] サイマルキャストの rid を表す汎用型

Rid列挙型を追加しました[ADD] RPC 機能を追加しました

SignalingOfferにrpcMethods: [String]?を追加しましたMediaChannelにrpcメソッドを追加しましたRPC メソッドを定義するための

RPCMethodProtocolプロトコルを追加しましたRPCMethodProtocolに準拠した以下の型を追加しましたRequestSimulcastRidRequestSpotlightRidResetSpotlightRidPutSignalingNotifyMetadataPutSignalingNotifyMetadataItem

RPC エラー応答の詳細を表す

RPCErrorDetail構造体を追加しましたRPC 成功応答を表す

RPCResponse<Result>ジェネリック構造体を追加しましたSoraErrorに RPC 関連のエラーケースを追加しました

2025.2.0¶

- 日付:

2025-09-18

- 対応 Sora:

2025.1.0 以降

- 対応 iOS:

14.0 以降

- 対応 libwebrtc:

m138.7204.0.3

ハイライト¶

MediaChannelHandlersにonDisconnect: ((SoraCloseEvent) -> Void)?を追加しましたonDisconnect: ((Error?) -> Void)?はonDisconnectLegacyという名前に変更され、非推奨になりました既存の

onDisconnect: ((Error?) -> Void)?では異常発生時のエラーは取得できても、正常に終了した際の理由などを取得することができませんでしたonDisconnect: ((SoraCloseEvent) -> Void)?を利用することで、正常に終了した際のステータスコードと理由も取得できるようになりますonDisconnect: ((Error?) -> Void)?からの移行については onDisconnect: ((Error?) -> Void)? から onDisconnect: ((SoraCloseEvent) -> Void)? への移行 をご確認ください

破壊的変更¶

CocoaPods でのライブラリ提供を廃止しました

シグナリング type: connect メッセージの

multistreamを自動で true に設定する仕様を廃止しましたMediaChannelHandlersのonDisconnect: ((Error?) -> Void)?をonDisconnectLegacyという名前に変更し、非推奨にしましたonDisconnect: ((SoraCloseEvent) -> Void)?への移行を推奨しますonDisconnectLegacy: ((Error?) -> Void)?は2027 年中に削除予定です移行については onDisconnect: ((Error?) -> Void)? から onDisconnect: ((SoraCloseEvent) -> Void)? への移行 をご確認ください

非推奨情報¶

Configuration.multistreamEnabledを非推奨にしましたSora 2025.1.0 でレガシーストリームが廃止されたため、この項目を非推奨にしました

合わせて

Configurationのイニシャライザの multistreamEnabled をオプション引数にし、デフォルト値を nil に変更しました2027 年中に削除予定です

変更履歴¶

[CHANGE] CocoaPods でのライブラリ提供を廃止しました

詳細は CocoaPods での提供終了について をご確認ください

[CHANGE] connect メッセージの

multistreamを自動で true に設定する仕様を廃止しましたConfiguration.role に .sendrecv を指定している場合に multistream を true に設定する仕様を廃止しました

Configuration.spotlightEnabled に .enabled を指定している場合に multistream を true に設定する仕様を廃止しました

Sora iOS SDK 2025.2.0 からは、connect メッセージには Configuration.multistreamEnabled に指定した値がそのまま設定されます

今後は Configuration.role に .sendrecv を指定している場合または Configuration.spotlightEnabled に .enabled を指定している場合に Configuration.multistreamEnabled に false を指定すると接続エラーになります

[CHANGE]

MediaChannelHandlersのonDisconnect: ((Error?) -> Void)?をonDisconnectLegacyという名前に変更し、非推奨にしました[UPDATE] WebRTC m138.7204.0.3 に上げました

[UPDATE]

Configuration.multistreamEnabledを非推奨にしましたConfigurationのイニシャライザの multistreamEnabled をオプション引数にし、デフォルト値を nil に変更しましたSora のデフォルト挙動に合わせる場合は、

Configurationのイニシャライザで mutlistreamEnabled を指定しないようにしてください

[UPDATE] Sora との接続が終了したときの状態を表す

SoraCloseEvent(enum) を追加しました[UPDATE]

MediaChannelHandlersにonDisconnect: ((SoraCloseEvent) -> Void)?を追加しましたonDisconnect: ((Error?) -> Void)?からの移行については onDisconnect: ((Error?) -> Void)? から onDisconnect: ((SoraCloseEvent) -> Void)? への移行 をご確認ください

[ADD] サイマルキャストの映像のエンコーディングパラメーター

scaleResolutionDownToを追加しましたscaleResolutionDownTo の詳細については Sora のドキュメントの サイマルキャスト機能 をご確認ください

[ADD] Sora から DataChannel シグナリングを切断する際に

"type": "close"メッセージを受信する機能を追加しましたDataChannel シグナリングが有効、かつ

ignore_disconnect_websocketが true、かつ Sora の設定でdata_channel_signaling_close_messageが有効な場合に受信することができます

[FIX] Sora から切断された場合の切断処理を修正し適切なエラーを

MediaChannelHandlers.onDisconnectで受け取ることができるようになりましたSora iOS SDK 2025.1.1 までは Sora から Close Frame を受け取ったり、ネットワークエラーが起きたりしても、WebSocket メッセージ受信失敗に起因する

SoraError.webSocketErrorしか受信できませんでしたが、以下の内容を受信できるようになりましたSora から Close Frame を受け取った場合のステータスコードと理由

ステータスコードが 1000 で正常に切断された場合も

MediaChannelHandlers.onDisconnectで通知されます

ネットワークエラーや Sora がダウンした場合のエラー内容

いままでは WebSocket メッセージ受信失敗時のエラーである

The operation couldn’t be completed. Socket is not connectedというエラーしか返せていなかった状態が改善されましたこの変更によって

MediaChannelHandlers.onDisconnectで受信するメッセージの内容は変わりますが、コールバックが発火するタイミングに変更はありません

2025.1.3¶

- 日付:

2025-07-28

- 対応 Sora:

2024.2.0 以降

- 対応 iOS:

14.0 以降

- 対応 libwebrtc:

m132.6834.5.2

[FIX] Sora の設定が、DataChannel 経由のシグナリングの設定、かつ、WebSocket の切断を Sora への接続が切断したと判断しない設定の場合に、SDP 再交換に失敗することがある問題を修正しました

WebSocket 経由から DataChannel 経由へのシグナリング切替時に

type: switchedとtype: re-offerをほぼ同時に受信した際、type: re-answerを WebSocket 経由で送信する前に WebSocket を切断してしまいtype: re-answerの送信に失敗することがあるためですDataChannel 経由へのシグナリング切替後でも、まだ WebSocket 経由で送信中のメッセージが存在する可能性を考慮し、余裕を持って切断するために 10 秒の待機時間を設けるようにしました

2025.1.2¶

- 日付:

2025-05-07

- 対応 Sora:

2024.2.0 以降

- 対応 iOS:

14.0 以降

- 対応 libwebrtc:

m132.6834.5.2

[FIX] マルチストリーム利用時に SDP 再ハンドシェイク中に SDK が終了処理をした際に EXC_BAD_ACCESS (不正なメモリアクセス) によりクラッシュする問題を修正しました

2025.1.1¶

- 日付:

2025-01-23

- 対応 Sora:

2024.2.0 以降

- 対応 iOS:

14.0 以降

- 対応 libwebrtc:

m132.6834.5.2

[FIX] WebRTC m132.6834.5.2 にアップデートしました

Apple 非公開 API を利用していたため、App Store Connect へのアップロードに失敗する問題に対応しました

2025.1.0¶

- 日付:

2025-01-21

- 対応 Sora:

2024.2.0 以降

- 対応 iOS:

14.0 以降

- 対応 libwebrtc:

m132.6834.5.1

[UPDATE] WebRTC m132.6834.5.1 にアップデートしました

[UPDATE] システム条件を変更しました

IPHONEOS_DEPLOYMENT_TARGET を 14.0 に変更

SwiftPM の platforms の設定を v14 に変更

CocoaPods の platform の設定を 14.0 に変更

[UPDATE]

SignalingOfferに以下の項目を追加しましたversionsimulcastMulticodecspotlightchannelIdsessionIdaudioaudioCodecTypeaudioBitRatevideovideoCodecTypevideoBitRate

[UPDATE]

SignalingNotifyに以下の項目を追加しましたtimestampspotlightNumberfailedConnectionIdcurrentStatepreviousState

[ADD]

ForwardingFilterに name と priority を追加しました[ADD] シグナリング connect 時にリスト形式の転送フィルターを設定するための項目を追加しました

ConfigurationとSignalingConnectにforwardingFiltersを追加しました

2024.3.0¶

- 日付:

2024-09-06

- 対応 Sora:

2024.1.0 以降

- 対応 iOS:

13.0 以降

- 対応 libwebrtc:

m127.6533.1.1

[CHANGE]

MediaChannelConfigurationを非推奨にしましたSDK 内部では利用していないため非推奨としています

現在ご利用の方はこのクラス定義をご自分のプロジェクトにコピーしてご利用ください

[UPDATE] libwebrtc

m127.6533.1.1にアップデートしました[UPDATE] SignalingOffer に

simulcast: Bool?を追加しました[UPDATE] システム条件を変更しました

macOS 14.6.1 以降

Xcode 15.4

WebRTC SFU Sora 2024.1.0 以降

[FIX] SignalingConnect の

metadata,signaling_notify_metadataが未設定 (nil) の場合に{}として送信されてしまう問題を修正しました未設定の場合は項目が含まれて送信されないように修正しました

この修正により、

Configuration.signalingConnectMetadataの値が未指定の場合は Sora の認証ウェブフックにmetadata,authn_metadataの項目が送信されなくなりますこの修正により、

Configuration.signalingConnectNotifyMetadataの値が未指定の場合は Sora のイベントウェブフックにmetadataの項目が送信されなくなります修正前の動作を維持して

{}を送信したい場合は、Configuration.signalingConnectMetadataおよびConfiguration.signalingConnectNotifyMetadataに中身が空の Encodable プロトコルに準拠したオブジェクトを指定してください例)

configuration.signalingConnectMetadata = [String: String]()

[FIX] 認証ウェブフック成功時に払い出された

simulcastの値が反映されない不具合に対応しました[FIX] スポットライト機能が有効の条件で

WrapperVideoEncoderFactoryのサイマルキャスト機能が有効になる不具合を修正しました利用上に不具合はありませんが、意図しないエンコーダーの設定になっていたため修正しました

[FIX] TURN URI に IPv6 アドレスが設定されている場合に接続ができない不具合を修正しました

TURN URI 文字列に対して、内部処理で意図しないエスケープ処理が行われていた問題を修正しました

2024.2.0¶

- 日付:

2024-04-23

- 対応 Sora:

2023.2.0 以降

- 対応 iOS:

13.0 以降

- 対応 libwebrtc:

m122.6261.1.0

[CHANGE] シグナリング connect メッセージの libwebrtc に含まれるバージョン文字列を変更しました

Android とフォーマットを統一しました

"Shiguredo-build M122 (M122.1.0 6b419a0)" から "Shiguredo-build M122 (122.6261.1.0 6b419a0)" に変更されます

[UPDATE] libwebrtc を m122.6261.1.0 に更新しました

libwebrtc の AV1 デコード機能の脆弱性対応が含まれています

[UPDATE] システム条件を変更しました

macOS 14.4.1 以降

Xcode 15.3

Swift 5.10

2024.1.0¶

- 日付:

2024-02-26

- 対応 Sora:

2023.2.0 以降

- 対応 iOS:

13.0 以降

- 対応 libwebrtc:

m121.6167.4.0

[CHANGE] Sora 2022.1.0 にて

metadata_listが廃止されたのに伴い、SignalingNotifyのmetadataListを削除しました代わりに

SignalingNotifyのdataで値を取得できます

[CHANGE] VideoView のバックエンドを RTCEAGLVideoView から RTCMTLVideoView に変更しました

libwebrtc のアップデートに伴い

RTCEAGLVideoViewがdeprecatedになったことに伴う修正です

[UPDATE] システム条件を変更しました

macOS 14.3.1 以降

WebRTC SFU Sora 2023.2.0 以降

CocoaPods 1.15.2 以降

Xcode 15.2

Swift 5.9.2

[UPDATE] CameraVideoCapturer のログを出力するようにしました

[UPDATE] libwebrtc のバージョンを 121.6167.4.0 に更新しました

HEVC (H.265) 対応パッチを含んだバージョンです

[UPDATE] 解像度に qHD (960x540) を追加しました

[UPDATE] CocoaPods を v1.15.2 に更新しました

[UPDATE] Sora 2023.2.0 で対応した

ForwardingFilterのversionとmetadataを追加しました[ADD]

VideoCodecにハードウェアアクセラレーターを利用した HEVC(H.265) の映像を送受信できるようにするコーデック指定H265を追加しました[ADD] リソースの逼迫により、送信する映像の品質が維持できない場合に、解像度やフレームレートのどちらを維持するかを指定できる設定

degradationPreferenceをWebRTCConfigurationに追加しました詳細については CPU やネットワーク帯域等逼迫時における映像品質優先項目の設定 をご確認ください

[FIX]

ForwardingFilterのactionを未指定にできるように修正しました[FIX]

SignalingNotifyに項目を追加しましたsessionIdkinddestinationConnectionIdsourceConnectionIdrecvConnectionIdsendConnectionIdstreamId

2023.3.1¶

- 日付:

2023-10-24

- 対応 Sora:

2023.1.0

- 対応 iOS:

13.0 以降

- 対応 libwebrtc:

m116.5845.6.1

[FIX] AVCaptureDevice.Format の選択時にフレームレートを考慮するように修正しました

フレームレートに 60 を設定しても、 AVFrameRateRange が 1-30 の AVCaptureDevice.Format が選択されてしまうケースがあったため修正しました

修正前は、カメラから同じ解像度の AVCaptureDevice.Format が複数取得された場合、最初に解像度が一致した AVCaptureDevice.Format を選択しており、フレームレートが考慮されていなかったことが原因です

2023.3.0¶

- 日付:

2023-09-13

- 対応 Sora:

2023.1.0

- 対応 iOS:

13.0 以降

- 対応 libwebrtc:

m116.5845.6.1

[CHANGE]

@available(*, unavailable)アトリビュートの項目を削除しましたSwift 5.9 以降

@available(*, unavailable)アトリビュートが禁止されたことによる対応です削除した項目を利用していた場合ビルドエラーが発生するため 利用不可項目の削除について を参照して対応をお願いします

[CHANGE]

@available(*, deprecated, ... )としていた非推奨項目を削除する非推奨であった項目について削除に移行しました

削除した項目を利用していた場合ビルドエラーが発生するため 利用不可項目の削除について を参照して対応をお願いします

[CHANGE]

PeerChannel.swiftとSignalingChannel.swiftのonConnectHandlerをonConnectに置き換えました既に他のファイルでは名称変更を行なっていたがこのファイルのみ変更が行われていなかったため対応する

[UPDATE] WebRTC 116.5845.6.1 に対応しました

[FIX]

MediaChannelのconnectionCount,publisherCount,subscriberCountに値が設定されない不具合を修正しましたSora のシグナリングメッセージ、 channel_upstream_connections, channel_downstream_connections が廃止された契機で値が設定されなくなっていました

Sora のシグナリングメッセージ、channel_sendrecv_connections, channel_sendonly_connections, channel_recvonly_connections, channel_connections を元に値を設定するよう修正

2023.2.0¶

- 日付:

2023-08-01

- 対応 Sora:

2023.1.0

- 対応 iOS:

13.0 以降

- 対応 libwebrtc:

m115.5790.7.0

[UPDATE] WebRTC 115.5790.7.0 に対応しました

[UPDATE] システム条件を変更しました

macOS 13.4.1 以降

WebRTC SFU Sora 2023.1.0 以降

Xcode 14.3.1

Swift 5.8.1

CocoaPods 1.12.1 以降

[ADD] サイマルキャストを VP9 / AV1 で利用できるようにしました

[ADD] 接続時に転送フィルターを指定できるようにしました

ConfigurationにforwardingFilterを追加しました詳細は 転送フィルターの設定 をご確認ください

[ADD] 接続時に映像コーデックパラメーターを指定できるようにしました

ConfigurationにvideoVp9Params,videoAv1Params,videoH264Paramsを追加しました詳細は 映像コーデックパラメーターの設定 をご確認ください

2023.1.0¶

- 日付:

2023-04-07

- 対応 Sora:

2022.2.0

- 対応 iOS:

13.0 以降

- 対応 libwebrtc:

m112.5615.1.0

[UPDATE] WebRTC 112.5615.1.0 に対応しました

[UPDATE] システム条件を変更しました

macOS 13.3 以降

Xcode 14.3

Swift 5.8

WebRTC SFU Sora 2022.2.0 以降

[UPDATE]

CameraSettingsのResolutionにuhd2160p,uhd3024pを追加しました[ADD]

ConfigurationにaudioStreamingLanguageCodeを追加しました[FIX] m107.5304.4.1 利用時、シグナリング時に EXEC_BAD_ACCESS が発生する事象を修正しました

RTCPeerConnection.offer()に渡すブロック内でRTCPeerConnection.close()を呼んでいるのが原因だと思われるため、 async/await を使って offer() の終了を待ってから close() するよう修正しましたRTCPeerConnection.offer()の実行が非同期で行われるようになりましたが、NativePeerChannelFactory.createClientOfferSDP()の用途では問題はありません

既知の問題¶

ネットワーク¶

現在、 Sora で IPv6 を有効にしていると Sora iOS SDK では接続できない事象が発生しています。Sora の設定により回避が可能です。Sora ドキュメント sora.conf の turn_fqdn を設定する をご確認ください。

映像のエンコーディングパラメータ¶

サイマルキャスト機能とスポットライト機能での映像のエンコーディングパラメータのうち、 Sora iOS SDK は adaptivePtime に現在対応していません。

クライアント側の証明書チェック¶

Sora iOS SDK は Sora とのシグナリングおよび TURN-TLS にて TLS を利用していますが、現在、SDK 側に証明書の検証を無効にする設定がないため、自己署名証明書をご利用いただくことができません。

FAQ¶

一般¶

Sora iOS SDK は有償ですか?¶

Sora iOS SDK はオープンソースライセンス Apache License 2.0 で配布しています。

Sora がなくても使えますか?¶

Sora iOS SDK は Sora 専用です。 Sora 以外の環境では動作しません。

Objective-C で使えますか?¶

使えません。 Sora iOS SDK は Swift 専用です。

ソースコードをダウンロードしたい¶

git clone などでソースコードをダウンロードする場合は、タグを指定するか master ブランチを選択してください。

develop ブランチは動作の保証ができませんので注意してください。

Bitcode に対応していますか?¶

対応しています。

サンプルコードはありますか?¶

サンプルコードは https://github.com/shiguredo/sora-ios-sdk-samples で提供しています。

設定¶

Sora iOS SDK が対応している音声コーデックを教えてください¶

Sora iOS SDK は以下の音声コーデックに対応しています。

Opus

Sora iOS SDK が対応している映像コーデックを教えてください¶

Sora iOS SDK は以下の映像コーデックに対応しています。

VP8

VP9

AV1

H.264

H.265

Sora iOS SDK はハードウェアアクセラレーターに対応していますか?¶

以下の映像コーデックで Video Toolbox を利用したハードウェアアクセラレーターに対応しています。

H.264

H.265

Sora の TURN 機能を無効にして利用できますか?¶

できません。

Sora iOS SDK は Sora を turn = false に設定して利用することはできません。

自己署名証明書は利用できますか?¶

できません。優先実装にて対応可能です。

AVAudioSession.Category は何を設定していますか?¶

Sora iOS SDK はマイクの利用有無に関わらず、 AVAudioSession.Category を .playAndRecord に設定しています。

それ以外のカテゴリを使用したい場合は接続後に変更が可能です。 AVAudioSession のプロパティを変更する も参考にしてください。

Sora iOS SDK で受信した音声の音量が小さいです¶

Sora iOS SDK のデフォルトで使用している AVAudioSession.Category の .playAndRecord はマイク利用が必要となる設定ですが、この場合受信する音量が小さくなります。

これは iOS の仕様です。必要に応じて AVAudioSession.Category を変更してください。

音声のステレオ送受信に対応していますか?¶

音声の送信、受信ともに対応していません。

接続¶

接続/切断処理の連続実行でクラッシュが発生する¶

接続/切断処理が実行される際、処理が完了する前に新しい処理が開始されると、 内部状態の不整合が発生してアプリケーションがクラッシュする可能性があります。 特に、ユーザーが接続/切断ボタンを短時間に連続してタップした場合などに発生しやすい問題です。

この問題を回避するには、以下のような対策を実施してください。

- 接続/切断処理の直列化

DispatchQueueなどを使用して接続/切断処理を順次実行し、 複数の処理が同時に実行されないようにします。- UI 操作の制御

接続/切断処理中はボタンのタップを無効化し、 ユーザーが連続して操作できないようにします。

具体的な実装例は sora-ios-sdk-quickstart

の ViewController.swift をご確認ください。

サポート¶

有償サポートは受けられますか?¶

Sora iOS SDK の有償サポートは提供していません。

質問やバグ報告はどこで行えますか?¶

Sora iOS SDK についての質問やバグ報告は Discord の #sora-sdk-faq チャンネルにお願いします。

ただし、 Sora のライセンス契約の有無に関わらず、応答時間と問題の解決を保証しませんのでご了承ください。

Issue の内容はどのように書けばいいですか?¶

使い方の質問やバグ報告であれば、次の開発環境のバージョンを「メジャーバージョン、マイナーバージョン、メンテナンスバージョン」まで含めて書いてください (Xcode 9.0 など) 。 これらの開発環境はメンテナンスバージョンの違いでも Sora iOS SDK の挙動が変わる可能性があります。

Sora

Sora iOS SDK

Mac OS X

Xcode

Swift

iOS

CocoaPods

リリース¶

リリースサイクルを教えてください¶

Sora のメジャーバージョンアップ後に、 Sora へ追従を目的としたバージョンアップを行います。

ただし、具体的なリリースサイクルはありません。

2025.1.x から 2025.2.x への移行¶

シグナリング の "type": "connect" メッセージの JSON に multistream 項目をデフォルトでは含めないように変更¶

2025.1.x までは必ず multistream を connect メッセージに含めていましたが、2025.2.x 以降はデフォルトでは multistream 項目を含めないようにしました。

経緯¶

Sora のバージョン 2025.1.0 からレガシーストリームが廃止され、connect メッセージの multistream 項目が廃止されました。

この変更に合わせて Sora iOS SDK でも connect メッセージの multistream 項目をデフォルトで送信しない仕様に変更しました。

これに伴い、デフォルトでは multistream を含めない挙動にするために Configuration の設定に応じて接続メッセージに multistream: true を自動的に設定する仕様も廃止しました。

connect メッセージに multistream を含める必要がある場合は引き続き Configuration を初期化する際に multistreamEnabled を指定してください。

移行方法¶

Sora 2025.1.0 以降リリースされた Sora を利用する場合は multistreamEnabled を指定しないようにしてください。

let config = Configuration(url: url,

channelId: channelId,

role: .sendrecv)

シグナリング の "type": "connect" メッセージの multistream を自動で true に設定する仕様を廃止¶

2025.1.x までは Configuration の設定時に条件に応じて自動的に connect メッセージに multistream: true を設定していましたが、2025.2.x では本仕様を廃止しました。

廃止の経緯は シグナリング の "type": "connect" メッセージの JSON に multistream 項目をデフォルトでは含めないように変更 の経緯に記載しています。

影響を受けるケース¶

自動的に multistream: true が設定される仕様に依存していた場合は影響を受ける可能性があります。

2025.2.x の移行で影響を受けるケース:

Sora がデフォルトでレガシーストリームを使うように設定されている、かつ

Configurationが以下のいずれかの設定になっている場合roleが.sendrecvである場合spotlightEnabledが.enabledである場合

移行方法¶

connect メッセージに multistream: true を含める必要がある場合は Configuration の multistreamEnabled に true を指定してください。

let config = Configuration(url: url,

channelId: channelId,

role: .sendrecv,

multistreamEnabled: true)

onDisconnect: ((Error?) -> Void)? から onDisconnect: ((SoraCloseEvent) -> Void)? への移行¶

Sora iOS SDK 2025.2.x から 引数に SoraCloseEvent を持った onDisconnect コールバックを MediaChannelHandlers に追加しました。

SoraCloseEvent には、Sora との接続が終了したときのステータスコードと切断理由、または Error が含まれています。

onDisconnect: ((SoraCloseEvent) -> Void)? に移行することにより、Sora から切断された理由をアプリケーションで取得することが可能になります。

警告

2025.1.x までの onDisconnect は onDisconnectLegacy に名前が変更になり、非推奨となりました。

移行法を参照し、どちらかの手段で移行してください。

移行方法¶

以下の 2 つの移行方法があります。

新 onDisconnect への移行¶

2025.2.x からは ((Error?) -> Void)? から ((SoraCloseEvent) -> Void)? に移行してください。

// 移行前

config.mediaChannelHandlers.onDisconnect = { [weak self] error in

guard let self = self else { return }

if let error {

// エラー内容を表示

print("エラー内容: \(error.localizedDescription)")

} else {

// 正常に切断された場合の処理

print("正常に切断されました")

}

}

// 移行後 (SoraCloseEvent のハンドリング処理を実装する)

config.mediaChannelHandlers.onDisconnect = { [weak self] event in

guard let self = self else { return }

switch event {

case .ok(let code, let reason):

// 正常に切断された場合の処理

print("切断コード: \(code)")

print("切断理由: \(reason)")

case .error(let error):

// エラー内容を表示

print("エラー内容: \(error.localizedDescription)")

}

}

SoraCloseEvent の定義は以下のようになっています。

enum SoraCloseEvent {

// 正常系

case ok(code: Int, reason: String)

// 異常系

case error(Error)

}

旧 onDisconnect を使い続ける¶

onDisconnect を onDisconnectLegacy に置き換えることで、旧 onDisconnect を使い続けることができます。

// onDisconnect を onDisconnectLegacy に置き換える

config.mediaChannelHandlers.onDisconnectLegacy = { [weak self] error in

guard let self = self else { return }

if let error {

// エラー内容を表示

print("エラー内容: \(error.localizedDescription)")

} else {

// 正常に切断された場合の処理

print("正常に切断されました")

}

}

2023.2.x から 2023.3.x への移行¶

利用不可項目の削除について¶

概要¶

@available(*, unavailable) および、 @available(*, deprecated, ... ) の項目について削除を行います。

これらの項目について利用している場合は 2023.3.0 でビルドエラーが発生します。以下のドキュメントを参考に移行への対応をお願いします。

経緯¶

@available(*, unavailable) について、Swift 5.9 以降 @available(*, unavailable) attribute が廃止となるため削除をします。

このアトリビュートはプロパティが廃止済みであることを伝えるためのものです。

@available(*, deprecated, ... ) については非推奨 (廃止予定) の項目について移行を促すために記載していたものです。

1 年以上経過しているため削除をします。 移行先の項目は廃止項目をご確認ください。

廃止項目¶

@available(*, unavailable) が指定されている項目¶

すでに廃止されており、Sora iOS SDK 2023.2.0 時点の SDK で利用した場合はビルドエラーが発生する項目です。 移行が未完了の場合は、以下を参考に移行をお願いします。

Configurationのurlシグナリング URL の複数指定が可能となったため廃止となりました。

urlCandidatesで代替してください。

ConfigurationのsignalingChannelHandlers廃止となりました。利用できません。

mediaChannelHandlersで代替してください。

ConfigurationのPeerChannelHandlers廃止となりました。利用できません。

mediaChannelHandlersで代替してください。

ConfigurationのsignalingChannelType廃止となりました。利用できません。

ConfigurationのwebSocketChannelType廃止となりました。利用できません。

ConfigurationのpeerChannelType廃止となりました。利用できません。

ConfigurationのallowsURLSessionWebSocketChannel廃止となりました。利用できません。

ConfigurationのvideoCapturerDevice廃止となりました。利用できません。

カメラの設定については

ConfigurationのcameraSettingsにて指定できます。カスタムキャプチャーについては

MediaStream.send(videoFrame:)を利用して映像フレームを送信してください。カメラの操作 も参考にしてください。

MediaChannelHandlersのwebSocketChannel廃止となりました。利用できません。

WebSocketChannelHandlersのonMessageHandleronReceiveに置き換えられました。

WebSocketChannelHandlersのonDisconnectHandler廃止となりました。利用できません。

WebSocketChannelHandlersのonPongHandler廃止となりました。利用できません。

WebSocketChannelHandlersのonSendHandler廃止となりました。利用できません。

WebSocketChannelHandlersのonDisconnect廃止となりました。利用できません。

WebSocketChannelHandlersのonPong廃止となりました。利用できません。

WebSocketChannelHandlersのonSend廃止となりました。利用できません。

WebSocketChannel廃止となりました。利用できません。

VideoCapturerDevice廃止となりました。利用できません。

VideoCapturer廃止となりました。利用できません。

カスタムキャプチャーについては

MediaStream.send(videoFrame:)を利用して映像フレームを送信してください。

VideoCapturerHandlers廃止となりました。利用できません。

カスタムキャプチャーについては

MediaStream.send(videoFrame:)を利用して映像フレームを送信してください。

CameraVideoCapturerのshared廃止となりました。利用できません。

起動中の

CameraVideoCapturerはCameraVideoCapturer.current!で取得できます。

CameraVideoCapturerのsettings廃止となりました。利用できません。

CameraSettingsに定義を行うように変更しています。

CameraVideoCapturerのcaptureDevicesCameraVideoCapturerのdevicesを利用して取得をおこなってください。

CameraVideoCapturerのcaptureDevice(for position: AVCaptureDevice.Position)CameraVideoCapturerのdevice(for position: AVCaptureDevice.Position)を利用して取得をおこなってください。

CameraVideoCapturerのsuitableFormat(for device: AVCaptureDevice, resolution: Any)廃止となりました。利用できません。

CameraVideoCapturerのformat(width: Int32, height: Int32, for device: AVCaptureDevica, frameRate: Int?)で代替してください。

CameraVideoCapturerのsuitableFrameRate(for format: AVCaptureDevice.Format, frameRate: Int)廃止となりました。利用できません。

CameraVideoCapturerのmaxFrameRate(_ frameRate: Int, for format: AVCaptureDevice.Format)で代替してください。

CameraVideoCapturerのcanStop廃止となりました。利用できません。

Sora との切断時にカメラは自動的に停止されます。

CameraVideoCapturerのstopWhenDone廃止となりました。利用できません。

Sora との切断時にカメラは自動的に停止されます。

CameraVideoCapturerのstopWhenDone廃止となりました。利用できません。

Sora との切断時にカメラは自動的に停止されます。

SignalingMetadata廃止となりました。利用できません。

メタデータは Any? を任意の型にキャストして利用してください。

SignalingClientMetadata廃止となりました。利用できません。

SignalingNotifyMetadataで代替してください。

SignalingNotifyEventType廃止となりました。利用できません。

SignalingNotifyConnection廃止となりました。利用できません。

この Struct の定義は

SignalingNotifyに集約されています。

SignalingNotifySpotlightChanged廃止となりました。利用できません。

この Struct の定義は

SignalingNotifyに集約されています。

SignalingNotifyNetworkStatus廃止となりました。利用できません。

この Struct の定義は

SignalingNotifyに集約されています。

DeviceInfoのmodel廃止となりました。利用できません。

@available(*, deprecated, ... ) が指定されている項目¶

Sora iOS SDK 2023.2.0 までは警告のみで内部的に移行先に値を設定しておりビルドエラーは発生しませんでした。項目自体を削除したため、以下を参考に移行をお願いします。 移行が未完了の場合は、以下を参考に移行をお願いします。

Roleのpublisher廃止となりました。利用できません。

sendonlyで代替してください。

Roleのsubscriber廃止となりました。利用できません。

recvonlyで代替してください。

Roleのgroup廃止となりました。利用できません。

sendrecvで代替してください。

RoleのgroupSub廃止となりました。利用できません。

recvonlyで代替してください。

Configurationのinit初期化時にマルチストリームの指定が必須となりました。

Configuration(url: url, channelId: soraChannelId, role: .recvonly, multistreamEnabled: false)のように指定してください。

ConfigurationのspotlightspotlightNumberに置き換えられました。

ConfigurationのactiveSpeakerLimitspotlightNumberに置き換えられました。

SignalingConnectのspotlightspotlightNumberに置き換えられました。

SignalingConnectのactiveSpeakerLimitspotlightNumberに置き換えられました。

SignalingNotifyのpublisherCount廃止となりました。利用できません。

channelSendonlyConnectionsとchannelSendrecvConnectionsの合計値で代替してください。

SignalingNotifyのsubscriberCount廃止となりました。利用できません。

channelRecvonlyConnectionsとchannelSendrecvConnectionsの合計値で代替してください。

SoraHandlersのonConnectHandleronConnectに置き換えられました。

SoraHandlersのonDisconnectHandleronDisconnectに置き換えられました。

SoraHandlersのonAddMediaChannelHandleronAddMediaChannelに置き換えられました。

SoraHandlersのonRemoveMediaChannelHandleronRemoveMediaChannelに置き換えられました。

MediaChannelHandlersのonConnectHandleronConnectに置き換えられました。

MediaChannelHandlersのonDisconnectHandleronDisconnectに置き換えられました。

MediaChannelHandlersのonAddStreamonRemoveStreamHandlerに置き換えられました。

MediaChannelHandlersのonDisconnectHandleronRemoveStreamに置き換えられました。

MediaChannelHandlersのonReceiveSignalingHandleronReceiveSignalingに置き換えられました。

MediaStreamHandlersのonSwitchVideoHandleronSwitchVideoに置き換えられました。

MediaStreamHandlersのonSwitchAudioHandleronSwitchAudioに置き換えられました。

CameraPosition起動時のカメラ設定は

Configuration.cameraSettings.positionの.frontまたは.backを設定します。起動後のカメラの切り替えは

CameraVideoCapturerのflip(_:completionHandler:)を使用します。カメラの操作 も参考にしてください。

CameraVideoCapturerのcurrentCameraDeviceCameraVideoCapturerのdeviceを利用して取得をおこなってください。

セットアップ¶

システム条件¶

Sora iOS SDK を利用するアプリケーションの開発に必要なシステム条件を次に示します。

iOS 14 以降

アーキテクチャ arm64 (シミュレーターの動作は未保証です)

Xcode 26.2 - Swift 5 言語モードでビルドしています

WebRTC SFU Sora 2025.2.0 以降

注釈

2025.1.x 系のリリースを最後に CocoaPods での提供を終了します。 詳細は「CocoaPods での提供終了について」をご確認ください。

Xcode プロジェクトのセットアップ¶

概要¶

Sora iOS SDK は Swift Package Manager を利用してアプリケーションに追加できます。

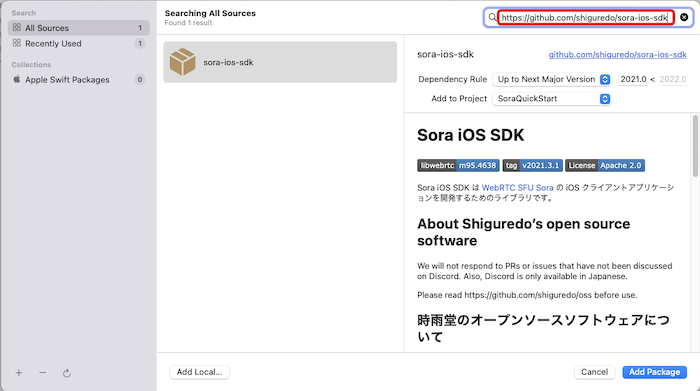

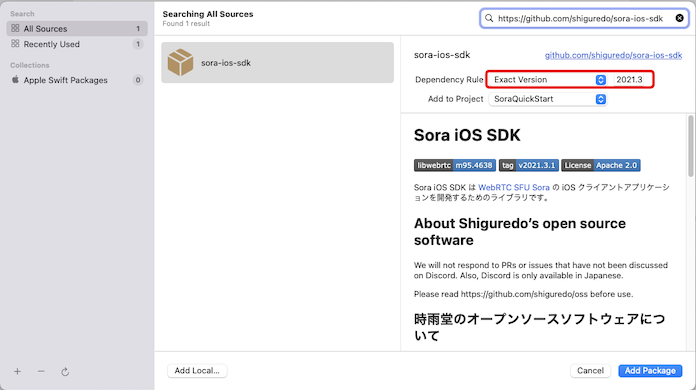

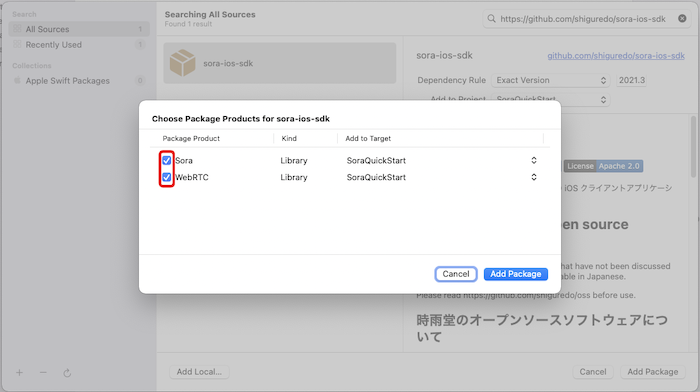

Swift Package Manager を利用する¶

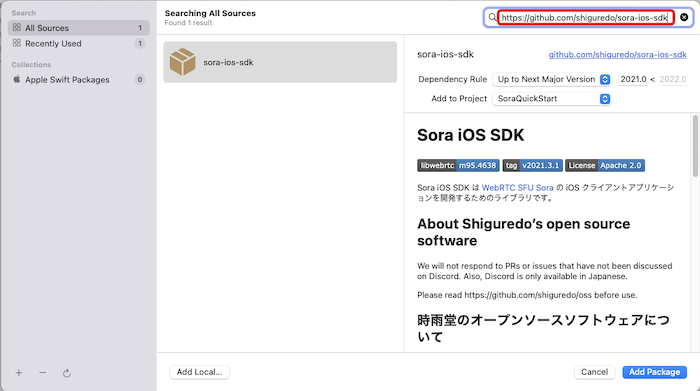

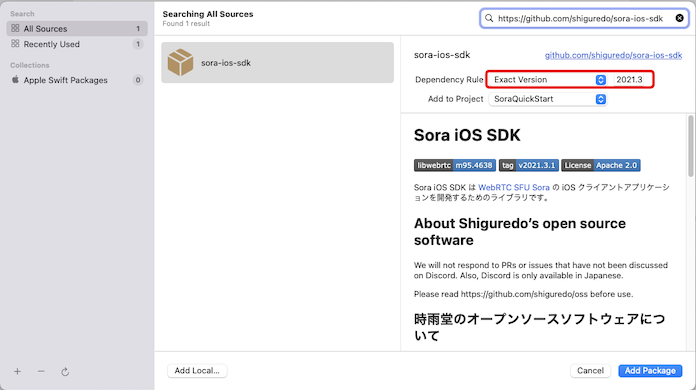

Xcode でパッケージを追加する¶

Xcodeのメニューから[File]-[Add Packages...] を選択します

検索ボックスに https://github.com/shiguredo/sora-ios-sdk を入力します

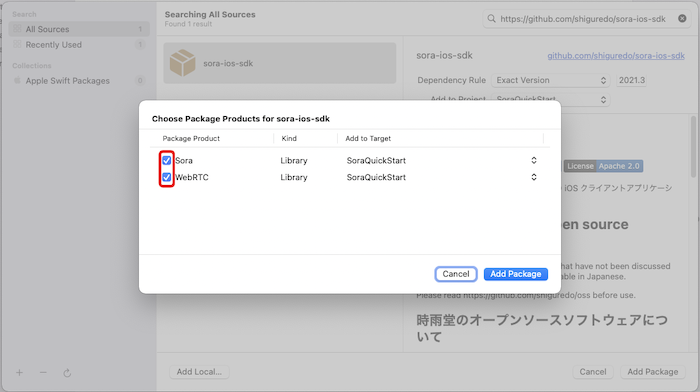

利用するSDK のバージョンを選択して [Add Package]を選択します

Sora, WebRTC の両方を選択して [Add Package]を選択します

Package.swift に追加する¶

Package.swift の dependencies に以下のように追加すると Sora iOS SDK を利用することができます。

let package = Package(

...

dependencies: [

.package(url: "https://github.com/shiguredo/sora-ios-sdk", from: "2025.1.1"),

],

targets: [

.target(

name: "MyApp",

dependencies: [

.product(name: "Sora", package: "sora-ios-sdk"),

]

)

]

)

カメラとマイクを許可する¶

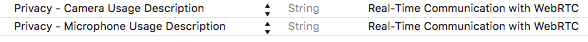

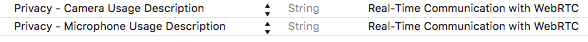

ナビゲーターエリアからプロジェクトエディターの Info タブを開き Custom iOS Target Properties にカメラとマイクの用途を記述します。 この記述を追加しないとアプリケーションが強制終了するので、必ず記述してください。

※ Xcode13 以前からのプロジェクトを利用する場合は、Info.plist ファイルに以下の記述を追加してください。

カメラの用途: "Privacy - Camera Usage Description"

マイクの用途: "Privacy - Microphone Usage Description"

設定例:

クイックスタート¶

この章では SoraQuickStart というサンプルアプリを使って、Sora iOS SDK を使ったシンプルな iOS アプリケーションを実行するまでの流れを紹介します。 この iOS アプリケーションを通じて、次の Sora iOS SDK の使い方を学べます。

メディアデータ (映像と音声) の送信と受信

送受信する映像の描画

端末のデバイス (カメラとマイク) の使用

ソースコードは sora-ios-sdk-quickstart リポジトリで配布しています。

用意するもの¶

バージョンなどの詳細な条件は システム条件 をご確認ください。

iOS 端末 (Sora iOS SDK はシミュレーターに対応していません)

Mac OS X と Xcode

Sora

Sora については、ここでは次の条件での運用を仮定します。 これは Sora のチュートリアル が完了した時と同様の条件です。 詳しくは Sora のドキュメントをご確認ください。

Sora のホスト名: "sora.example.com"

デモ機能: 有効

HTTPS を使用

WebSocket の接続に wss を使用

メディアチャネル ID: "sora"

サンプルアプリケーションをビルドする¶

コードを書く前に、サンプルアプリケーション SoraQuickStart をビルドして実行してみましょう。

ソースコードをダウンロードする¶

サンプルアプリケーションのソースコードは sora-ios-sdk-quickstart リポジトリで配布しています。

master ブランチをクローンもしくはダウンロードしてください。

接続情報を設定する¶

接続する Sora のシグナリング URL とチャネル ID は Environment.swift に設定します。

SoraQuickStart ディレクトリ配下の Environment.example.swift を元に Environment.swift を作成してください。

$ cp SoraQuickStart/Environment.example.swift SoraQuickStart/Environment.swift

SoraQuickStart の Xcode プロジェクトを開き、接続する Sora のシグナリング URL とチャネル ID を設定します。 接続する Sora が認証メタデータを必要とする場合は signalingConnectMetadata を設定してください。

Environment.swift:

// 接続する Sora のシグナリング URL

static let url = URL(string: "wss://sora.example.com/signaling")!

// チャネル ID

static let channelId = "sora"

// 認証メタデータ

static let signalingConnectMetadata: Encodable? = ["access_token": "YOUR_TOKEN"]

ビルドして実行する¶

iOS 端末をマシンに接続します (Sora iOS SDK はシミュレーターに対応していません。実機を利用してください) 。ビルドターゲットのアーキテクチャに接続した iOS 端末を選択してビルド・実行します (メニュー "Product" > "Run") 。

ビルド対象アーキテクチャの選択:

Sora に接続する¶

アプリケーションが起動したら、 Connect ボタンをタップすると Sora に接続します。 接続に成功するとカメラとマイクの使用許可を求めるダイアログが表示されます。 許可後、上下のビューにカメラの映像が表示されれば接続成功です。

接続できなかった場合は Sora の URL やネットワークの状態を確認してください。 Sora に接続できない もご確認ください。

実装上の注意点¶

再接続について¶

Sora と Sora iOS SDK は再接続をサポートしていません。 意図しない接続解除が発生した場合、 Sora iOS SDK が自動的に再接続を行うことはありません。 再度同一のチャネルに接続する必要があれば、新たに接続処理を行うように実装してください。

カメラのマイクの初期化¶

カメラとマイクはパブリッシャーの接続時に初期化されます。

Sora iOS SDK では、カメラの映像は CameraVideoCapturer が扱います。

(Info.plist にプライバシーの設定を記述しないとアプリケーションが落ちますので注意してください )。

映像データの送信の仕組み¶

CameraVideoCapturer が取得したカメラの映像は、配信ストリームを通じて Sora に送信されます。

サンプルアプリケーションのポイント¶

サンプルアプリケーションにて実装されている Sora iOS SDK 開発のポイントを以下に記載します。

Sora の接続には「 Sora のシグナリング URL 」と「チャネル ID 」が必要です。接続に関する設定を

Configurationにセットします。Sora の接続は

Soraオブジェクトのconnect(configuration:webRTCConfiguration:handler:)を呼びます。映像の描画は

VideoViewオブジェクトが行います。VideoViewはストリームのvideoRendererプロパティにセットします。端末のカメラとマイクはパブリッシャーの接続時に初期化されて使用可能になります。

その他のサンプルコード¶

下記のリポジトリでその他の様々なサンプルコードを公開しています。

Sora によるピア接続の流れ¶

Sora におけるピア接続の流れ¶

この節では Sora を使うピア接続の流れを説明します。 Sora iOS SDK を使えば詳細を知らなくてもアプリケーションを作れますが、 Sora とクライアントの挙動を理解しておくとトラブルに対処しやすいでしょう。

Sora は WebSocket でシグナリングの通信を行い、シグナリングメッセージを JSON フォーマットで送受信します。 WebSocket の接続が切れるとシグナリングを継続できなくなります。

クライアントは WebSocket で Sora に接続し、以下に示す connect メッセージを送信します (シグナリングメッセージの詳細は Sora のドキュメント をご確認ください) 。

connect メッセージ例:

{

"type": "connect",

"role": "upstream",

"channel_id": "Spam",

"metadata": "1234abcd"

}

Sora は connect メッセージを受信すると認証を行います。 認証が成功すればクライアント ID (1 接続についてユニークな値) を発行し、クライアント ID を含む offer メッセージを返します。

offer メッセージ例:

{

"type": "offer",

"sdp": "<Offer 用 SDP>",

"client_id": "<ユニークな ID>"

}

offer メッセージには Offer SDP が含まれます。 クライアントはこの段階でピア接続オブジェクト (WebRTC ライブラリの RTCPeerConnection オブジェクト) を生成し、 Offer SDP を remote description にセットします。 また offer メッセージは ICE に関する設定を含む場合があり、その設定はピア接続オブジェクトに反映されます。

このときにピア接続オブジェクトによって ICE candidate が生成されたら、クライアントは candidate メッセージを生成して ICE candidate の内容を Sora に送信します。

Offer SDP が無事に remote description にセットされたら、クライアントは Answer SDP を生成します。 Answer SDP はピア接続オブジェクトの local description にセットされ、それが成功すれば Answer SDP を含む answer メッセージを Sora に送信します。

answer メッセージ例:

{

"type": "answer",

"sdp": "<Answer 用 SDP>"

}

ICE 接続が成功すればピア接続完了です。 ピア接続中は接続状態などの情報がシグナリングで通信されます。 ICE 接続もしくはシグナリング接続が解除されるとピア接続は終了します。

Sora に接続する¶

概要¶

Sora への接続処理の概要について記載しています。

接続の手順¶

Sora への接続は次の手順で行います。

Configuration を生成する。

Sora オブジェクトの connect メソッド を呼ぶ。

import Sora

// シグナリング URL とチャネル ID を指定する

let url = URL(string: "wss://sora.example.com/signaling")!

let soraChannelId = "sora"

let config = Configuration(url: url,

channelId: soraChannelId,

role: .recvonly)

// 接続する

Sora.shared.connect(configuration: config) { mediaChannel, error in

// 接続に失敗するとエラーが渡される。

// 接続に成功すると error は nil

if let error = error {

// 接続エラー時の処理

...

}

// 接続成功時の処理

// 映像を描画するビューをストリームにセットする等

...

}

}

Configuration は Sora への接続情報などの設定を保持するオブジェクトです。 Sora のシグナリング URL 、チャネル ID 、ロールをセットします。

次に Configuration を引数として Sora オブジェクトの connect メソッド を呼びます。このとき Sora オブジェクトは Sora.shared プロパティでシングルトンを取得できます。

このメソッドは Sora への接続を行い、接続の成否に関わらず handler: に指定されたブロックを実行します。

接続が成功すると MediaChannel がブロックの引数として渡されます。

MediaChannel は接続後の操作を行うためのオブジェクトです。

connect メソッド の型と引数は次の通りです。

func connect(configuration: Configuration,

webRTCConfiguration: WebRTCConfiguration = WebRTCConfiguration(),

handler: (_ mediaChannel: MediaChannel?, _ error: Error?) -> Void)

configuration: 接続情報です。シグナリング URL とチャネル ID を指定します。webRTCConfiguration: WebRTC に関する設定です (省略可) 。handler: 接続試行後に実行するブロックです。ブロックの型は(MediaChannel?, Error?) -> Voidです。ブロックの引数は次の通りです。mediaChannel: 接続に成功するとメディアチャネルが渡されます。失敗時はnilです。error: 接続に失敗するとエラーが渡されます。成功時はnilです。

MediaChannel は映像データを扱うストリームを複数保持します。 映像はストリームを通じて Sora と送受信されます。

ストリームは送信か受信のいずれかを担当し、ロールによって扱う数が異なります。 シングルストリームにおいて、送信と受信のストリームはそれぞれ 1 つです。 つまり、シングルストリームでは 1 回の接続につき送信か受信かのいずれか一方しか行えません。 1 台の端末で映像の送受信を行う場合は、送信と受信で 2 回の接続が必要です。

接続後の映像の送受信については 映像を描画する を参考にしてください

DataChannel 経由のシグナリング¶

Sora と DataChannel を経由したシグナリング通信を行うための接続方法について記載します。 詳しい仕様は Sora のドキュメント をご確認ください。

DataChannel 経由のシグナリングを有効にするには、 Configuration の dataChannelSignaling プロパティに true をセットしてください。

WebSocket が閉じたときに Sora に接続が切断されたと判断して欲しくない場合は ignoreDisconnectWebSocket プロパティに true をセットしてください。

var config = Configuration(url: url,

channelId: channelId,

role: .sendrecv)

// DataChannel 経由のシグナリングを有効にする

config.dataChannelSignaling = true

// WebSocket が閉じたことを無視する

config.ignoreDisconnectWebSocket = true

イベントハンドラ¶

DataChannel に関するイベントハンドラは MediaChannelHandlers に用意しています。 主なイベントハンドラは以下の通りです。

/// シグナリングが DataChannel 経由に切り替わったタイミングで呼ばれるクロージャー

public var onDataChannel: ((MediaChannel) -> Void)?

/// DataChannel のメッセージ受信時に呼ばれるクロージャー

public var onDataChannelMessage: ((MediaChannel, String, Data) -> Void)?

音声コーデックの設定¶

Sora 接続時に送信する音声についてコーデックの指定ができます。

音声のコーデックは Configuration の

audioCodecに AudioCodec を設定します。

var config = Configuration(url: url,

channelId: channelId,

role: .sendrecv)

// 音声コーデックを opus に設定する

config.audioCodec = .opus

音声ビットレートの設定¶

Sora 接続時に送信する音声についてビットレートの指定ができます。

音声のビットレートは Configuration の

audioBitRateに設定します。

var config = Configuration(url: url,

channelId: channelId,

role: .sendrecv)

// 音声ビットレートを 32 kbps に設定する

config.audioBitRate = 32

映像コーデックの設定¶

Sora 接続時に送信する映像についてコーデックの指定ができます。

映像のコーデックは Configuration の

videoCodecに VideoCodec を設定します。利用できる映像コーデックは VP8 / VP9 / H.264 / H.265 / AV1 です。未指定の場合は Sora のデフォルト値が設定されます。

var config = Configuration(url: url,

channelId: channelId,

role: .sendrecv)

// 映像コーデックを VP8 に設定する

config.videoCodec = .vp8

映像ビットレートの設定¶

Sora 接続時に送信する映像についてビットレートの指定ができます。

映像のビットレートは Configuration の

videoBitRateに設定します。

var config = Configuration(url: url,

channelId: channelId,

role: .sendrecv)

// ビデオビットレートを 3000 kbps に設定する

config.videoBitRate = 3000

映像コーデックパラメーターの設定¶

送信する映像コーデックの設定と合わせて、映像コーデックのパラメータを指定可能です。

この機能は role が sendrecv または sendonly の場合に利用できます。

指定できる値の内容については以下の Sora ドキュメントをご確認ください。

var config = Configuration(url: url,

channelId: channelId,

role: .sendrecv)

// 映像コーデックの設定は VP9 / AV1 / H.264 のいずれか 1 種類のみです

// 利用しない映像コーデックパラメーターは設定しないでください

// VP9 の場合は profile_id の設定が可能です

config.videoCodec = .vp9

config.videoVp9Params = ["profile_id": 0]

// AV1 の場合は profile の設定が可能です

// config.videoCodec = .av1

// config.videoAv1Params = ["profile": 0]

// H.264 の場合は profile_level_id の設定が可能です

// config.videoCodec = .h264

// config.videoH264Params = ["profile_level_id": "42e01f"]

転送フィルターの設定¶

転送フィルター機能は、Sora 側でクライアントへ転送する音声や映像のパケットをフィルターする機能です。 詳しくは Sora ドキュメント をご確認ください。

この機能は role が sendrecv または recvonly の場合にのみ利用できます。

フィルターを設定する¶

Sora 接続時に Configuration.forwardingFilters を設定します。

設定例¶

以下の例は、自分の接続に対して、次の条件で映像または音声の受信をブロックします。

connection_id が "S8YEN0TSE13JDC2991NG4XZ150" の場合は音声と映像の受信をブロックする、または client_id が "screen-share" の場合は音声の受信をブロックする

var config = Configuration(url: url,

channelId: channelId,

role: .sendrecv)

let forwardingFilter = ForwardingFilter(

action: .block,

rules: [

[

ForwardingFilterRule(field: .connectionId,

operator: .isIn,

values: ["S8YEN0TSE13JDC2991NG4XZ150"]),

],

[

ForwardingFilterRule(field: .clientId,

operator: .isIn,

values: ["screen-share"]),

ForwardingFilterRule(field: .kind,

operator: .isIn,

values: ["audio"]),

]

],

)

config.forwardingFilters = [forwardingFilter]

プロキシ・サーバーの設定¶

プロキシ・サーバーを経由した通信を行う場合は、 Configuration の proxy プロパティにプロキシ情報をセットしてください。

HTTP プロキシに対応しています

SOCKS プロキシも設定できますが、動作を確認していません

HTTP の CONNECT メソッドは HTTPS ではなく HTTP で送信します

Proxy-Authorization ヘッダーを利用した Basic 認証に対応しています

iOS の Wi-Fi に設定されたプロキシの項目を参照しません

var config = Configuration(url: url,

channelId: channelId,

role: .sendrecv)

// proxy 情報の設定を行う

config.proxy = Proxy(host: "proxy.example.com",

port: 3128,

agent: nil,

username: "ham",

password: "egg")

複数のシグナリング URL を指定する¶

Sora iOS SDK では、 urlCandidates に複数のシグナリング URL を指定することができます。

Sora iOS SDK は全ての URL に対して接続を試行し、最初に成功した接続をシグナリングに使用します。 このため、1台でも正常なサーバーが残っていれば Sora への接続が成功します。 クラスター機能は複数の URL を指定しなくても利用できますが、冗長性を高めるために複数 URL の指定を推奨します。

let urlCandidates = [

URL(string: "wss://sora1.example.com/signaling")!,

URL(string: "wss://sora2.example.com/signaling")!,

URL(string: "wss://sora3.example.com/signaling")!

]

var config = Configuration(urlCandidates: urlCandidates,

channelId: channelId,

role: .sendrecv)

実際にシグナリングに利用されている URL は

MediaChannelクラスのconnectedUrlフィールドから確認できます。

クラスター機能利用時のシグナリングのリダイレクト¶

クラスター機能を有効にすると、 Sora から、 type: offer の代わりに type: redirect が送られてくることがあります。 この場合、Sora iOS SDK は Sora の接続を一度切断し、 type: redirect で指定された location に再接続します。

CPU やネットワーク帯域等逼迫時における映像品質優先項目の設定¶

映像の配信中に、CPU やネットワーク帯域などの制約を受けて、指定された解像度やフレームレートを維持できないことがあります。 そのような場合に、優先する項目を設定することができます。

例えば、文章が中心のスライドを利用するプレゼンテーションなど、フレームレートより解像度を優先した映像の配信を行いたい場合に、解像度を優先するように設定できます。

設定は Configuration の webRTCConfiguration.degradationPreference から行います。

degradationPreference には以下の値を設定できます。

disabled ... 何もしない

balanced ... バランスを取る

maintainResolution ... 解像度の維持を優先する

maintainFramerate ... フレームレートの維持を優先する (デフォルトの挙動です)

let config = Configuration(url: url,

channelId: soraChannelId,

role: .sendonly)

// リソースが逼迫した場合は解像度の維持を優先する

config.webRTCConfiguration.degradationPreference = .maintainResolution

マルチストリーム機能¶

概要¶

重要

Sora ではデフォルトでマルチストリームを利用します。

マルチストリーム機能とは、1 つのピア接続で複数のストリームを管理する機能です。 詳しくは Sora ドキュメント をご確認ください。

マルチストリーム機能で接続する¶

Sora はデフォルトでマルチストリームを利用するので、特に設定は必要ありません。

接続例:

let config = Configuration(url: url,

channelId: channelId,

role: .sendrecv)

// ストリームが追加されたときに行う処理です。

config.mediaChannelHandlers.onAddStream = { [weak self] stream in

...

}

// ストリームが削除されたときに行う処理です。

config.mediaChannelHandlers.onRemoveStream = { [weak self] error in

...

}

Sora.shared.connect(configuration: config) {

...

}

マルチストリーム機能で接続すると、同一のチャネル ID に接続されているすべてのストリームが MediaChannel に追加されます。

同一のチャネル ID のストリームが増減すると MediaChannel が保持するストリームも増減します。

ストリームが追加されると MediaChannel のイベントハンドラ MediaChannelHandlers.onAddStreamHandler が、削除されると onRemoveStreamHandler が呼ばれます。

映像を描画するには、各ストリームにそれぞれ VideoRenderer をセットします。

イベントハンドラを利用して映像ビューを用意するとよいでしょう。

サイマルキャスト機能¶

概要¶

サイマルキャスト (Simulcast) 機能は配信時に 1 つの RTCPeerConnection から複数種類のエンコードした映像を配信する機能です。 詳細は Sora ドキュメント サイマルキャスト機能 をご確認ください。

サイマルキャストを有効にする¶

シグナリング接続時に Configuration.simulcastEnabled プロパティを true に設定します。

視聴時に受信する映像を Configuration.simulcastRequestRid または Configuration.simulcastRid で指定可能です。

注釈

Sora 2025.2.0 より、シグナリング接続時に視聴するサイマルキャスト映像の指定先として Configuration.simulcastRequestRid が追加されました。

これに伴い既存の Configuration.simulcastRid は非推奨になり、 2027 年 12 月リリース予定の Sora では利用できなくなります。

サイマルキャストの Configuration 設定例¶

ビットレートや解像度が低い場合、 3 段階の画質の切替ができないことがあります。 詳細は Sora ドキュメント 現時点でのサイマルキャストの仕様 をご確認ください。

// 接続の設定を行います。

let config = Configuration(url: soraURL,

channelId: soraChannelId,

role: role)

// サイマルキャストの有効化

config.simulcastEnabled = true

// サイマルキャスト受信時の映像を指定

// Sora 2025.2.x 以降を利用の場合は simulcastRequestRid を指定

config.simulcastRequestRid = .r0

// Sora 2025.1.x 以前を利用の場合は simulcastRid のみが指定可能

config.simulcastRid = .r0

// 動画のコーデックを指定します

config.videoCodec = .vp8

// 十分な解像度、ビットレートを指定しないとサイマルキャストの映像が 3 本になりません

config.videoBitRate = 15000

// 解像度、フレームレートの設定

config.cameraSettings = CameraSettings(resolution: .hd1080p, frameRate: 30)

危険

2022 年 6 月のリリースよりスポットライト機能で複数画質を送信するにはサイマルキャスト機能を有効化する必要があります

スポットライト機能¶

概要¶

スポットライト機能は、一定の音量を超えて音声を発している参加者の画質を優先して配信する機能です。 詳細は以下ドキュメントをご確認ください。

スポットライト機能を有効にする¶

Sora 接続時に以下を設定します

Configuration.spotlightEnabledプロパティに.enabledを指定します。Configuration.simulcastEnabledプロパティを指定します。自分の映像について、音声に応じて画質の切り替えを行う場合は

trueを指定します。自分の映像について、音声に応じて画質の切り替えを行なわない場合は

falseを指定します。

追加で以下のオプションが設定可能です

Configuration.spotlightNumberプロパティでスポットライトのフォーカス数を指定します。Configuration.spotlightFocusRidプロパティでフォーカスされている映像の rid を指定します。Configuration.spotlightUnfocusRidプロパティでフォーカスされていない映像の rid を指定します。

スポットライトの Configuration 設定例¶

// 接続の設定を行います。

let config = Configuration(url: soraURL,

channelId: soraChannelId,

role: role)

// サイマルキャストを有効にします。

// 自分が話していない時は画質が落ちた状態で配信されます。

config.simulcastEnabled = true

// スポットライトを有効にします。

config.spotlightEnabled = .enabled

// スポットライトのフォーカスする配信数を設定可能です。

config.spotlightNumber = 2

// スポットライトがフォーカスされている映像、フォーカスされていない映像の rid を設定可能です。

// 映像を受信しない設定も可能です。

config.spotlightFocusRid = .r1

config.spotlightUnfocusRid = .none

// 動画のコーデックを設定します。

config.videoCodec = .vp8

任意の JSON 値の送受信¶

シグナリングメッセージの一部には、ユーザーが任意の JSON 値を送受信するためのフィールドが含まれます。 本章では JSON 値の送受信について説明します。 なお、シグナリングメッセージの詳細は WebRTC SFU Sora ドキュメント - WebSocket 経由のシグナリング をご確認ください。

シグナリングメッセージ¶

シグナリングメッセージは Signaling 列挙型と種別ごとのクラスで表されます。

メッセージの種別と対応する Signaling 列挙子の定義を次に示します。

詳細は API リファレンス をご確認ください。

type: connect

Signaling.connect(SignalingConnect)

type: offer

Signaling.offer(SignalingOffer)

type: answer

Signaling.answer(SignalingAnswer)

type: update

Signaling.update(SignalingUpdate)

type: candidate

Signaling.candidate(SignalingCandidate)

type: notify(SignalingNotify)

Signaling.notify(SignalingNotify)

type: ping

Signaling.ping(SignalingPing)

type: pong

Signaling.pong(SignalingPong)

type: disconnect

Signaling.disconnect

type: push

Signaling.push(SignalingPush)

上記のうち、任意の JSON 値を含むことができるメッセージとプロパティを次に示します。

type: connect (送信のみ)

metadatanotifyMetadata

type: notify (受信のみ)

authnMetadataauthzMetadatametadata

type: push (受信のみ)

data

任意のJSON 値を送信する¶

任意の JSON 値を含むことができる送信用のメッセージは type: connect のみです。

metadata と notifyMetadata のメタデータを指定できます。

メタデータは Configuration の次のプロパティで指定できます。

どちらも Encodable プロトコルに準拠した値を指定します。

metadata->Configuration.signalingConnectMetadatanotifyMetadata->Configuration.signalingConnectNotifyMetadata

これらのプロパティの値は JSON に変換されて送信されます。

基本的なデータ型 (Bool, Int, Float, String, Array, Dictionary) は Encodable に対応しているので、

これらの値の組み合わせであればエンコード処理を実装する必要はありません。

上記のプロパティの内容と生成される JSON を次に示します。

// {"type":"connect", "metadata":"contents", ...}

config.signalingConnectMetadata = "contents"

// {"type":"connect", "metadata":{"key":"value"}, ...}

config.signalingConnectMetadata = ["key": "value"]

送信されるメタデータの内容を確認するには、デバッグログを有効にしてシグナリングの内容をコンソールに出力してください。 詳細は SDK のログをコンソールに出力する をご確認ください。

受信した任意の JSON 値を取得する¶

受信用のメッセージの type: notify と type: push の一部のプロパティは任意の JSON 値を含むことができます。

任意の JSON 値の型は Any? です。

受信した JSON 値は JSONSerialization クラスで解析されます。

解析後のオブジェクトは NSString, NSNumber, NSArray, NSDictionary, NSNull のいずれかです。

プロパティはシグナリング用のイベントハンドラで取得できます。 受信したメッセージ及び同メッセージを含む WebSocket メッセージを取得できるイベントハンドラを次に示します。 WebSocket メッセージはテキストなので、手動で JSON を解析する必要があります。

MediaChannelHandlers.onReceiveSignaling: 受信したメッセージを取得します。WebSocketChannelHandlers.onReceive: 受信したメッセージを含む WebSocket メッセージを取得します。

イベントハンドラで JSON 値を取得する例を次に示します。

// MediaChannelHandlers でメッセージを取得する

mediaChannel.handlers.onReceiveSignaling = { signaling in

switch signaling {

// type: notify

case .notify(let notify):

switch notify.eventType {

case "connection.created":

// メタデータに含まれる JSON 値 (Any) を任意の型にキャストする

if let metadata = notify.metadata as? [String: Any] {

print("metadata => \(metadata)")

}

if let authnMetadata = notify.authnMetadata as? [String: Any] {

print("authn => \(authnMetadata)")

}

if let authzMetadata = notify.authzMetadata as? [String: Any] {

print("authz => \(authzMetadata)")

}

...

// 他のイベント種別でも同様に処理する

case "connection.created":

...

default:

...

}

// type: push

case .push(let push):

if let data = push.data as? [String: Any] {

print("data => \(data)")

}

...

default:

...

}

}

// WebSocket メッセージを手動で解析する場合

mediaChannel.webSocketChannel.handlers.onReceive = { message in

switch message {

case .text(let text):

// 受信したシグナリングのテキストデータを JSON データとして解析する

if let data = text.data(using: .utf8) {

do {

if let json = try JSONSerialization.jsonObject(with: data, options: []) as? [String: Any] {

switch json["type"] as? String {

case "notify":

// type: notify

print("notify metadata => \(json["metadata"])")

...

case "push":

// type: push

print("push data => \(json["data"])")

...

default:

...

}

}

} catch let error {

// JSON の解析に失敗した場合のエラー処理

// ここに来ることはないので無視してよい

}

}

...

case .binary(_):

// シグナリングでバイナリデータは来ないので何もしなくてよい

...

}

}

カメラの操作¶

CameraVideoCapturer と AVCaptureDevice¶

Sora iOS SDK では、カメラの操作は CameraVideoCapturer を通して行います (以下、「キャプチャー」と表します) 。

キャプチャーはカメラを表す AVCaptureDevice と 1 対 1 で対応し、端末が搭載するカメラの数だけキャプチャーが存在 (あるいは生成) します。

デフォルトの設定では、前面カメラと背面カメラそれぞれの AVCaptureDevice に対応する 2 つのキャプチャーを用意しています。

前面カメラのキャプチャーは front 静的プロパティで、背面カメラのキャプチャーは back 静的プロパティで取得できます。

利用可能な AVCaptureDevice のリストは CameraVideoCapturer.devices 静的プロパティで取得できます。

AVCaptureSession¶

キャプチャーの映像は AVCaptureSession によって管理されます。

AVCaptureSession は captureSession プロパティで取得できます。

映像の流れ¶

キャプチャーが取得した映像は、映像フレームに変換されて stream プロパティのストリームに渡されます。

stream プロパティに nil をセットすれば、キャプチャーの映像はいずれのストリームにも流れません (カメラは停止されません) 。

デフォルトの設定では、Sora に接続すると自動的にカメラが起動され、配信ストリームがキャプチャーにセットされます。

解像度と最大フレームレート¶

カメラ (AVCaptureDevice) は複数の解像度と最大フレームレートの組み合わせに対応しています。

この情報は AVCaptureDevice.Format に含まれます (以下、「フォーマット」と表します) 。

フォーマットの内容は AVCaptureDevice ごとに異なります。

いずれの端末も前面カメラと背面カメラで解像度と最大フレームレートが異なります。

カメラの起動にはフォーマットとフレームレートを指定する必要があります。

AVCaptureDevice が対応するフォーマットを取得するには format(width:height:for:frameRate:) 静的メソッドを使います。

最も近い解像度でかつ指定したフレームレートに対応するフォーマットを取得できます。

必ずしも希望する解像度が使えるとは限りません。また、フォーマットが対応していないフレームレートを指定した場合は無視されます。適切な値を設定するよう注意してください。

カメラの起動時に指定するフレームレートは、フォーマットが対応する最大フレームレート以下である必要があります。

たとえば、最大フレームレートが 30fps であるフォーマットを使う場合、起動時に指定するフレームレートは 30fps 以下でなければなりません。

フォーマットで使用できる最大フレームレートは maxFrameRate(_:for:) 静的メソッドで取得できます。

このメソッドは、指定したフォーマットが対応するフレームレートの幅のうち、指定したフレームレートに最も近いフレームレートを返します。

たとえば 40fps を指定した場合、指定したフォーマットが 40fps 以上に対応していれば 40fps を返します。

40fps に対応していなければ、対応する最大フレームレート (30fps など) を返します。

カメラの操作が行われるディスパッチキュー¶

カメラの操作は専用のディスパッチキューで行われます。

カメラの起動と停止¶

カメラを起動する¶

デフォルトの設定では、カメラは配信開始時に自動的に起動します。

このときのカメラの設定は Configuration に指定する CameraSettings によります。

CameraSettings では次の項目を指定できます:

解像度 (

resolutionプロパティ)フレームレート (

frameRateプロパティ)配信開始時のカメラの位置 (

positionプロパティ)カメラの起動の有無 (

isEnabledプロパティ)

配信開始時にカメラを停止しておき、あとから任意のタイミングで起動する場合は isEnabled に false を指定します。

手動でカメラを起動する手順を次に示します:

起動したいカメラに対応する

AVCaptureDeviceを取得します。使用するフォーマットを決めます。 使用可能なフォーマットは

format(width:height:for:frameRate:)で取得できます。使用するフレームレートを決めます。 2. で取得したフォーマットと希望するフレームレートを

maxFrameRate(_:for:)の引数に与えて実行すると、 その値を上限とする使用可能なフレームレートを取得できます。 もし 60fps を指定しても、フォーマットが対応する上限が 30fps であれば 30fps を返すので注意してください。start(format:frameRate:completionHandler:)) を実行してカメラを起動します。 起動処理の終了後、起動の成否に関わらずcompletionHandler:が実行されます。

カメラを停止・再起動する¶

映像の配信が終了すると、起動中のカメラも自動的に停止します。

(映像を配信しない場合でも CameraSettings.isEnabled が true であれば停止します) 。

起動中のカメラを一時的に停止するには stop(completionHandler:) を実行します。

停止したカメラを再起動するには start(format:frameRate:completionHandler:) か restart(completionHandler:) を実行します。

restart(completionHandler:) は停止前と同じ設定でカメラを再起動します。

また、 MediaChannel.setVideoHardMute(Bool) を利用する方法もあります。

映像のハードミュート をご確認ください。

起動中のカメラの設定を変更する¶

起動中のカメラのフォーマットとフレームレートは change(format:frameRate:completionHandler:) で変更できます。

このメソッドは指定した設定でカメラを再起動します。

カメラの位置を切り替える¶

カメラの前面と背面を切り替えるには flip(_:completionHandler:) 静的メソッドを実行します。

このメソッドは起動中のカメラの位置と反対のカメラを起動します。

このときに使われるフォーマットとフレームレートは、起動中のカメラの設定に近い値が検索されます。

任意の設定を使いたい場合は、起動中のカメラを停止してから任意のカメラを起動してください。

カメラの映像を加工する¶

CameraVideoCapturerHandlers イベントハンドラの onCapture を実装します (handlers プロパティでイベントハンドラにアクセスできます) 。

onCapture にセットするクロージャーはカメラの映像フレームを受け取り、ストリームに渡すための映像フレームを返す必要があります。

その他の操作¶

その他の操作は AVCaptureDevice を利用してください。

映像の描画¶

映像を描画する¶

ストリームが扱う映像は、ロールに関わらず VideoView (もしくは VideoRenderer プロトコルを実装したオブジェクト) で描画可能です。

サンプルコードを次に示します:

@IBOutlet weak var videoView: VideoView!

// 接続する

Sora.shared.connect(configuration: config) {

chan, error in

// エラー処理は省略

...

// VideoView をセットする

chan!.mainStream.videoRenderer = self.videoView

}

1 つのストリームにセットできる VideoView は 1 つです。

マルチストリーム機能ではストリームごとに異なる VideoView をセットする必要があります。

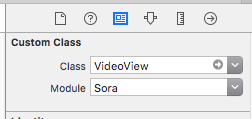

Interface Builder で VideoView を配置する¶

Interface Builder で VideoView をウィンドウに配置する場合は、次の手順で設定します。

ウィンドウに UIView を配置する

インスペクタを開き、 "Custom Class" の次の設定を変更する

"Class": "VideoView" を指定する

"Module": "Sora" を指定する

独自の映像レンダラーを実装する¶

VideoView 以外の映像レンダラーを独自に実装したい場合は、 VideoRenderer プロトコルを実装したクラスを用意します。

映像フレームを加工・編集する¶

映像フレーム (VideoFrame) は映像レンダラーに渡される前のタイミングで加工・編集が可能です。

加工・編集を行うには VideoFilter プロトコルを実装したクラスのオブジェクトを、ストリームの videoFilter プロパティにセットして使用します。

映像フレームは CMSampleBuffer から生成可能です (音声データを含む CMSampleBuffer は非対応です) 。

詳しくは API リファレンスをご確認ください。

任意の映像を送信する¶

任意の映像を送信するには、映像フレームを生成して配信ストリームの send(videoFrame:) メソッドの引数に渡します。

映像の送受信の停止時の描画について¶

ストリームによる映像の送受信が停止したときの VideoView の挙動は 未定義 です。

現在、弊社の SDK ではプラットフォームによって映像ビューの挙動が異なることを確認しています。 iOS では映像が止まったように見え、 Android とブラウザでは黒い画面が表示されます。 これらの現象は WebRTC ライブラリの実装に依存しており、各種 Sora SDK では特に手を加えていません。

Sora iOS SDK で仕様を定めない理由は次の通りです。

WebRTC は映像の送受信の停止時の描画について定義していません。

映像の送受信の停止時に描画コンポーネントがすべき挙動はアプリケーションによって異なります。 あるアプリケーションでは黒い画面を表示したいかもしれませんし、他のアプリケーションでは最後に描画した映像を表示し続けたいかもしれません。

以上の理由から、 SDK は特定の挙動を保証していません。 映像の送受信の停止時の処理はユーザー側で実装して頂く必要があります。

最も単純な方法は、停止時の描画を行うビューを用意することです。

VideoView とは別にビューを用意しておき、停止時に切り替えます。

参考として切替の方法の例を次に挙げておきます。

停止時に

VideoViewを隠し、用意したビューを表示します。基本的にこの方法を推奨します。// VideoView を隠す videoView.isHidden = true // 代わりのビューを表示する anotherView.isHidden = false

停止時に表示するビューを

VideoViewのサブビューに追加します。黒い画面や画像などの単純な映像を表示したり、VideoViewの回転やリサイズに追従したりする場合に向きます。// 黒い画面を表示するビューを VideoView に追加する blackView = UIView(frame: videoView.bounds) blackView.backgroundColor = UIColor.black videoView.addSubview(blackView) // Auto Layout の設定 blackView.translatesAutoresizingMaskIntoConstraints = false blackView.leadingAnchor.constraint(equalTo: videoView.leadingAnchor).isActive = true blackView.trailingAnchor.constraint(equalTo: videoView.trailingAnchor).isActive = true blackView.topAnchor.constraint(equalTo: videoView.topAnchor).isActive = true blackView.bottomAnchor.constraint(equalTo: videoView.bottomAnchor).isActive = true // 再開時はサブビューから取り除く blackView.removeFromSuperview()

端末の回転の検出について¶

Sora iOS SDK は、カメラの起動時に UIDevice の beginGeneratingDeviceOrientationNotifications() を、停止時に endGeneratingDeviceOrientationNotifications を実行します。これは libwebrtc のカメラ操作の仕様です。

アプリケーションで同メソッドを実行する際は、 beginGeneratingDeviceOrientationNotifications() と endGeneratingDeviceOrientationNotifications() を必ず対に実行するように注意してください。

音声の操作¶

用語¶

RTCAudioTrack (音声トラック)¶

AudioTrack は 1 接続に存在する音声のストリーミングデータを表現するオブジェクトです。 配信する音声トラックは Sora のルールにより 1 本です。受信する音声トラックは接続数分あります。

例えば 3 人で通話している場合、配信する音声トラックは 1 本、受信する音声トラックは 2 本存在します。

RTCAudioTrackSink¶

RTCAudioTrackSink は送信または受信した音声トラックごとに、音声データのコールバックを受け取るプロトコルです。

音声トラックから音声データを取得するには、この RTCAudioTrackSink を利用します。

音声をミュートする¶

音声をミュートするには メディアストリーム (MediaStream) の audioEnabled プロパティに false をセットします。

ただし送信音声についてミュートした場合、マイクは停止しませんので注意してください。

// 指定の ConnectionID を持つ受信 Stream の音声のミュート状態を切り替える

private func handleMuteReceiveStream(connectionId: String) {

// 受信したストリームのリストを取得する

// Sora 接続成功時に取得する MediaChannel を mediaChannel に保持しているものとする

let downstreams = mediaChannel?.receiverStreams ?? []

// downstreams が空の場合は何もしない

guard downstreams.count > 0 else {

return

}

for stream in downstreams {

// 指定のコネクションIDを持つ Stream の audioEnabled を切り替える

if stream.streamId == connectionId {

stream.audioEnabled = !stream.audioEnabled

}

}

}

受信した音声の音量を変更する¶

ロール が Role.recvonly または Role.sendrecv のとき、 メディアストリーム (MediaStream) の remoteAudioVolume プロパティで受信ストリームの音量が変更できます。

このプロパティは 0 から 10 の値をとります。

0 をセットすると音声は出力されません。

送信ストリームで送信する音声の音量は変更できません。

let config = Configuration(url: url,

channelId: channelId,

role: .sendrecv)

// 送信または受信のストリームが追加されたときのイベントハンドラ

config.mediaChannelHandlers.onAddStream = { [weak self] stream in

// クロージャーの実行時、 self が存在する場合のみ処理を続けます。

guard let self = self else {

return

}

// 受信ストリームのときのみ音量変更を行う

if stream.streamId != config.publisherStreamId {

stream.remoteAudioVolume = 3.0

}

}

受信した音声データを取得する¶

音声トラックごとに音声データを取得するには RTCAudioTrackSink プロトコルを利用します。

このプロトコルを実装したクラスを MediaStream の addAudioTrackSink(_:) で音声トラックに関連付けることで音声データを受信できるようになり、

removeAudioTrackSink(_:) を呼ぶか、自分もしくはリモートの配信クライアントがチャネルを離脱することで音声トラックとの関連付けが解除されます。

以下に音声データ受信の実装例を示します。

// このサンプルコードは RTCAudioTrackSink を用いて

// 音声データを WAV ファイルに保存するというシナリオ

// になっています。

//

// WAV 保存処理など RTCAudioTrackSink の使い方に

// 直接影響しない処理は実装を省略してあります。

import Sora

import WebRTC

/// RTCAudioTrackSink の実装例です。

final class RTCAudioTrackSinkExample: NSObject, RTCAudioTrackSink {

private let fileHandle: FileHandle

/// MARK: RTCAudioTrackSink protocol の実装

func onData(

_ audioData: Data,

bitsPerSample: Int,

sampleRate: Int,

numberOfChannels: Int,

numberOfFrames: Int

) {

// ここには onData コールバックで取得した音声データ処理を実装してください。

// 重い処理を行う場合は、別スレッドに処理を移譲してください。

writeWAV(audioData)

}

func preferredNumberOfChannels() -> Int { -1 }

/// MARK: この class 特有の処理

init(fileURL: URL) throws {

FileManager.default.createFile(atPath: fileURL.path, contents: nil)

self.fileHandle = try FileHandle(forWritingTo: fileURL)

super.init()

}

/// WAV ファイルへの書き込み処理

func writeWAV(audioData: Data) {}

/// リソースを解放する処理

func close() {

try? fileHandle.close()

}

}

final class Receiver {

private var connectionTask: ConnectionTask?

private var mediaChannel: MediaChannel?

// RTCAudioTrackSink は SDK 側で保持しないため、アプリ側で保持してください。

// MediaStream は 1 つの RTCAudioTrack を持ち、RTCAudioTrack には複数の RTCAudioTrackSink を

// 関連付けることができるため、RTCAudioTrackSink はリストで保持します。

private var sinksByStreamId: [String: (stream: MediaStream, sinks: [RTCAudioTrackSink])] = [:]

func start() {

var config = Configuration(

url: URL(string: "wss://example.com/signaling")!,

channelId: "my-channel",

role: .recvonly

)

// 自分もしくはリモートの配信クライアントがチャネルに参加した際の処理

config.mediaChannelHandlers.onAddStream = { [weak self] stream in

guard let self else { return }

let url = FileManager.default.temporaryDirectory

.appendingPathComponent("\(stream.streamId).wav")

guard let sink = try? RTCAudioTrackSinkExample(fileURL: url) else { return }

// MediaStream の保持する RTCAudioTrack に RTCAudioTrackSink を関連付けます

stream.addAudioTrackSink(sink)

// アプリ側で RTCAudioTrackSink を保持します。

// ここで保持した RTCAudioTrackSink はリソース解放処理を行う際に利用されます。

let entry = sinksByStreamId[stream.streamId]

let sinks = (entry?.sinks ?? []) + [sink]

sinksByStreamId[stream.streamId] = (stream: stream, sinks: sinks)

}

// リモートの配信クライアントがチャネルから切断した際の処理

config.mediaChannelHandlers.onRemoveStream = { [weak self] stream in

guard let self else { return }

// onRemoveStream で RTCAudioTrack が解放されると RTCAudioTrackSink も自動で解除されるため、

// removeAudioTrackSink を呼ぶ必要はありません。

if let entry = sinksByStreamId[stream.streamId] {

for sink in entry.sinks {

// RTCAudioTrackSink のリソース解放はアプリ側の責務です。

(sink as? RTCAudioTrackSinkExample)?.close()

}

sinksByStreamId[stream.streamId] = nil

}

}

// 切断されたときの処理

config.mediaChannelHandlers.onDisconnect = { [weak self] _ in

guard let self else { return }

for (_, entry) in sinksByStreamId {

for sink in entry.sinks {

// RTCAudioTrackSink のリソース解放はアプリ側の責務です。

(sink as? RTCAudioTrackSinkExample)?.close()

}

}

sinksByStreamId.removeAll()

}

connectionTask = Sora.shared.connect(configuration: config) { [weak self] mediaChannel, error in

if let error { print("connect failed: \(error)") }

self?.mediaChannel = mediaChannel

}

}

// MediaStream は MediaChannel.streams などから取得できます。

func stopReceivingAudio(stream: MediaStream) {

if let entry = sinksByStreamId[stream.streamId] {

for sink in entry.sinks {

// 明示的に RTCAudioTrackSink との関連付けを解除したい

// 場合は removeAudioTrackSink を利用します。

stream.removeAudioTrackSink(sink)

// RTCAudioTrackSink のリソース解放

(sink as? RTCAudioTrackSinkExample)?.close()

}

sinksByStreamId[stream.streamId] = nil

}

}

func stop() {

// 解放処理は onDisconnect に寄せる

connectionTask?.cancel()

mediaChannel?.disconnect(error: nil)

mediaChannel = nil

}

}

音声データについて¶

コールバックに入ってくる音声データは非圧縮の 16 bit PCM (Pulse Code Modulation) 形式です。

onData コールバックについて¶

RTCAudioTrackSink の onData コールバックには音声データ以外の情報も含まれています。

/// 音声データ受信コールバック。

///

/// - Parameters:

/// - audioData: PCM 形式音声データ。

/// - bitsPerSample: 1 サンプルあたりのビット数。

/// libwebrtc では PCM 形式の音声データは 16 bit 固定のため、常に 16 が渡されます。

/// - sampleRate: サンプルレート (単位: Hz)。

/// - numberOfChannels: 音声データのチャンネル数。

/// モノラルなら 1、ステレオなら 2 が渡されます。

/// - numberOfFrames: audioData に含まれるフレーム数。

func onData(_ audioData: Data,

bitsPerSample: Int,

sampleRate: Int,

numberOfChannels: Int,

numberOfFrames: Int)

注意

onData コールバック実装の注意点

onData は 10 ms ごとに libwebrtc の音声処理スレッド上で呼び出されるコールバックであるため、 onData 内部で時間のかかる処理を行う場合、libwebrtc の音声処理がブロックされてしまいます。そのため onData 内部で時間のかかる処理を行わず、別スレッドで処理を行うようにしてください。

RTCAudioTrackSink と RTCAudioTrack の関連付けについて¶

RTCAudioTrackSink と RTCAudioTrack の関連付けは 1:1 を前提に実装されています。1 つの RTCAudioTrackSink を複数の RTCAudioTrack に同時に関連付ける 1:N の利用は想定していません。 一方で、1 本の RTCAudioTrack に対して複数の RTCAudioTrackSink を関連付けることは可能であり、同一の RTCAudioTrack から各 RTCAudioTrackSink はそれぞれ独立して音声データを受け取ります。

RTCAudioTrackSink と RTCAudioTrack の関連付け解除について¶

通常、自分もしくはリモートの配信クライアントがチャネルを離脱した際に、RTCAudioTrack と RTCAudioTrackSink の関連付けは自動で解除されます。

明示的に関連付けを解除したい場合は、 MediaStream の removeAudioTrackSink(_:) を呼び出してください。

任意の音声を送信する¶

WebRTC ライブラリの制約により、 Sora iOS SDK ではマイク入力以外の音声を送信できません。ご了承ください。

AVAudioSession のプロパティを変更する¶

重要

iOS 14.0 で、音声モードをデフォルト以外からデフォルトに戻したときに音声が出力されない事象を確認しています。その場合は端末を iOS 14.1 以降にアップデートしてください。

Sora iOS SDK では、AVAudioSession のプロパティを変更する簡易的な API として、 Sora.setAudioMode メソッド を用意しています。

この API は AVAudioSession の次のプロパティを変更します

音声モード (

AVAudioSession.Mode)音声カテゴリ (

AVAudioSession.Category)音声カテゴリオプション (

AVAudioSession.CategoryOptions)音声経路 (

AVAudioSession.PortOverride)

ピア接続の設定や端末の状況によっては設定が反映されない場合があるので注意してください。

Sora.setAudioMode メソッド の型と引数は以下の通りです。

mode: AudioMode

AudioMode は Sora iOS SDK で利用可能な 3 種類の音声モードです。

default

default の音声モードを利用します。音声カテゴリ、音声出力先の指定ができます。

videoChat

videoChat の音声モードを利用します。音声カテゴリは

playAndRecord、音声出力先はスピーカーを使用します

voiceChat

voiceChat の音声モードを利用します。音声カテゴリは

playAndRecord、音声出力先の指定ができます。

options:

AVAudioSession.CategoryOptions指定は任意です。デフォルトで

allowBluetooth、allowBluetoothA2DP、allowAirPlayが設定されています。指定した場合はデフォルトの音声カテゴリオプションは設定されず、指定した音声カテゴリオプションのみが設定されます。

AudioMode の指定方法および AVAudioSession のプロパティ設定内容¶

AudioMode はモード毎にそれぞれ異なる引数を取ります。 指定する引数の内容と、指定された引数によって設定される AVAudioSession のプロパティの値は以下のとおりです。

default(category: AVAudioSession.Category, output: AudioOutput)音声モードに

defaultを設定します音声カテゴリに引数で指定された category を設定します

output には AudioOutput の

defaultまたはspeakerを指定しますoutput に

speakerが指定されていた時、音声カテゴリオプションにdefaultToSpeakerが追加で設定されます

videoChat音声モードに

videoChatが設定されます音声カテゴリに

playAndRecordが設定されます

voiceChat(output: AudioOutput)音声モードに

voiceChatを設定します音声カテゴリに

playAndRecordを設定しますoutput には AudioOutput の

defaultまたはspeakerを指定しますoutput に

speakerが指定されていた時、音声カテゴリオプションにdefaultToSpeakerが追加で設定されますoutput に

speakerが指定されていた時、音声経路にspeakerが設定されます

設定例¶

以下に Sora.setAudioMode メソッド を利用した AVAudioSession のプロパティ変更の例を示します。

import Sora

// 接続時のコールバック onConnect で音声モードを変更する

config.mediaChannelHandlers.onConnect = { [weak self] _ in

// setAudioMode を利用して、AVAudioSession のプロパティを変更する

// AudioSession は以下のように設定される

// - Category : playAndRecord

// - Mode : default

// - CategoryOptions : defaultToSpeaker, allowBluetooth, allowBluetoothA2DP, allowAirPlay

// - output に speaker を設定することで defaultToSpeaker が設定される

// - options は未指定のときと同様の設定。ここでは設定方法の例として記載している。

let result = Sora.shared.setAudioMode(.default(category: .playAndRecord, output: .speaker), options: [.allowBluetooth, .allowBluetoothA2DP, .allowAirPlay])

// 必要に応じてエラーハンドリングを行う

switch result {

case .success():

// 成功

case .failure(let error):

// 失敗

}

}

さらに細かい設定を行う場合は AVAudioSession の継承クラスである libwebrtc の RTCAudioSession を使用して設定が可能です。

設定を行った結果、libwebrtc の動作に影響が出て、正常に動作しなくなる可能性があるため、libwebrtc の挙動を理解した上で設定をしてください。

音声モードを変更するタイミング¶

音声モードの変更は 接続完了後 に行ってください。 Sora iOS SDK は接続完了時に接続設定に従って音声カテゴリを変更するので、接続完了前にセットした音声モードは接続完了時に上書きされます。

その他の操作¶

音声の出力は AVAudioSession により管理されているため、その他の操作は AVAudioSession を利用してください。

マイクのパーミッションについて¶

マイクのパーミッションは配信時にのみ要求されます。 マイクを使う場合は、 必ず Info.plist にマイクの用途を記述してください。

ミュート機能¶

アプリを利用している iOS 端末からの音声および映像の配信をミュートする機能です。

用語¶

インジケーター¶

iOS 14 以降では、アプリがマイクやカメラを使用中、画面の最上部ステータスバーにオレンジ色の点 (または四角) や緑色の点が表示されます。

このインジケーターはマイクまたはカメラの片方のみが使用中の場合でも表示され続けます。

インジケーターについては Apple サポートページ https://support.apple.com/ja-jp/108331 をご確認ください。

ソフトミュート¶

インジケーターが点灯したままの音声・映像ミュートです。マイクデバイスおよびカメラデバイスは使用中の状態となっています。 音声の場合は無音フレーム、映像の場合は黒塗りフレームを送出し続けている状態です。

ハードミュート¶

インジケーターが消灯する音声・映像ミュートです。マイクデバイスおよびカメラデバイスは使用されていない状態であり、 音声および映像はフレーム送出自体がされない状態です。

音声のハードミュート利用について¶

iOS が提供する音声モジュールではマイクによる入力とスピーカーによる出力がセットで管理されています。 音声ハードミュートの切り替えにはこの音声モジュール自体の再起動を伴うため音声出力が一瞬途切れることがあります。 また、内部エラーが発生した際には音声に関する動作が不安定になる可能性があります。 音声ハードミュート機能の実運用については事前に十分な動作検証を行ってください。

映像のハードミュート利用について¶

映像については特別な理由がない限りはハードミュートを利用してください。

映像ハードミュート有効化時はカメラインジケーターが消灯します。 これはカメラデバイスからのデータ送信が完全に停止されたことを意味し、 ユーザーに対して物理的なデバイスアクセスが行われていないことを確実に伝えることができます。 プライバシー保護の観点から、最も安全な選択肢です。

音声のハードミュート¶

音声のハードミュート有効化¶

Sora iOS SDK で音声のハードミュートを有効にするには MediaChannel.setAudioHardMute(Bool enable) を利用します。

このメソッドの引数に true を指定することで、マイクデバイスの入力を無効にします。

このタイミングで iOS 端末のマイクインジケーターが消灯します。

また、音声パケットは一切送出されない状態となります。

Sora 接続時にマイクインジケーターを点灯させないで開始する¶

Sora への接続設定 Configuration.initialMicrophoneEnabled に false を指定することで

接続確立時にマイク入力無効状態で開始します。

このとき、iOS 端末のマイクインジケーターは点灯せず、音声パケットは送出されません (音声ハードミュート相当)。

Configuration.initialMicrophoneEnabled のデフォルト値は true です。

音声が送出されるようにするには MediaChannel.setAudioHardMute(false) を実行します。

音声のハードミュート無効化¶

音声のハードミュート有効化 で有効化したハードミュートを無効にするには

MediaChannel.setAudioHardMute(Bool enable) を利用します。

このメソッドの引数に false を指定することで、マイクデバイスの入力を再開します。

このタイミングで iOS 端末のマイクインジケーターが点灯します。

また、音声パケットの送出も再開されます。

音声のハードミュート機能実装サンプル¶

// setAudioHardMute を使った音声ハードミュートの実行例です。

// 接続や UI 部分のうち、ハードミュート処理に不要な部分は省略しています。

import Sora

import UIKit

final class AudioHardMuteViewController: UIViewController {

// 接続完了後に設定される MediaChannel です。

var mediaChannel: MediaChannel?

// マイクのハードミュート状態です。

private var isMicHardMuted = false

// マイクのハードミュートボタンの UI 部品です。

@IBOutlet weak var micHardMuteButton: UIBarButtonItem?

// マイクのハードミュートをトグルします。ボタンにアクションとして紐付けられている想定です。

@IBAction func onMicHardMuteButton(_ _: UIBarButtonItem) {

// 接続していない場合や音声アップストリームがない場合は何もしません。

guard let mediaChannel = mediaChannel, mediaChannel.senderStream?.hasAudioTrack == true else {

return

}

let nextMuted = !isMicHardMuted

// ハードミュートを有効化します。

if let error = mediaChannel.setAudioHardMute(nextMuted) {

// エラー時のログ出力等

_ = error

} else {

isMicHardMuted = nextMuted

updateMicButton(isMuted: nextMuted)

}

}

// ミュート状態によってボタンの表示を更新します。

private func updateMicButton(isMuted: Bool) {

micHardMuteButton?.image = UIImage(systemName: isMuted ? "mic.slash" : "mic")

}

}

Tip

アプリの実装例については sora-ios-sdk-samples をご確認ください。

音声のソフトミュート¶

通信処理によらないクライアントレイヤーの音声ミュートです。

音声のソフトミュート有効化¶

Sora iOS SDK で音声のソフトミュートを有効にするには MediaChannel.setAudioSoftMute(Bool enable) を利用します。

このメソッドの引数に true を指定することで、音声トラックを無効にします。

このときマイクデバイス由来の音声は配信されず、代わりに無音のフレーム(デジタルサイレンスパケット)を送出する状態となります。

ただしマイクデバイスの入力は有効状態のままのため、iOS 端末のマイクインジケーターは点灯したままになります。

音声のソフトミュート無効化¶

音声のソフトミュート有効化 で有効化したソフトミュートを無効にするには

MediaChannel.setAudioSoftMute(Bool enable) を利用します。

このメソッドの引数に false を指定することで音声トラックが有効になり、マイクデバイスの音声が配信されるようになります。

音声のソフトミュート機能実装サンプル¶

// setAudioSoftMute を使った音声ソフトミュートを行う例です。

// 接続や UI のうちソフトミュートに不要な部分は省略しています。

import Sora

import UIKit

final class AudioSoftMuteViewController: UIViewController {

// 接続完了後に設定される MediaChannel です。

var mediaChannel: MediaChannel?

// マイクのソフトミュート状態を保持します。

private var isMicSoftMuted = false

// マイクのソフトミュートボタンです。

@IBOutlet weak var micSoftMuteButton: UIBarButtonItem?

// マイクのソフトミュートをトグルします。ボタンにアクションとして紐付けてください。

@IBAction func onMicSoftMuteButton(_ _: UIBarButtonItem) {

// 接続していない場合や音声アップストリームがない場合は何もしません。

guard let mediaChannel = mediaChannel, mediaChannel.senderStream?.hasAudioTrack == true else {

return

}

let nextMuted = !isMicSoftMuted

// ソフトミュートします。

if let error = mediaChannel.setAudioSoftMute(nextMuted) {

// エラー時のログ出力等

_ = error

} else {

isMicSoftMuted = nextMuted

updateMicButton(isMuted: nextMuted)

}

}

private func updateMicButton(isMuted: Bool) {

micSoftMuteButton?.image = UIImage(systemName: isMuted ? "mic.slash" : "mic")

}

}

Tip

アプリの実装例については sora-ios-sdk-samples をご確認ください。

映像のハードミュート¶

映像のハードミュートには 2 つの方法があります。

基本は MediaChannel.setVideoHardMute(Bool enable) の利用を推奨します。

独自のキャプチャ制御等が必要な場合は CameraVideoCapturer の stop() と restart() による直接制御を利用してください。

注釈

MediaChannel.setVideoHardMute(Bool enable) は CameraVideoCapturer の stop() と restart() を

利用しやすくラップしたメソッドです。

黒塗りフレームを送出してから停止する¶

映像パケット断は受信側からは通信障害かハードミュートによるものかの判別ができません。 このため受信側のクライアント実装によっては、映像が停止した時点のフレームを表示し続けることがあります。 ハードミュートを有効化する前にソフトミュートによる黒塗りフレーム送出状態にしておくことで不自然な表示になることを防ぐことができます。

映像のハードミュート有効化¶

MediaChannel.setVideoHardMute(Bool enable) によるハードミュート¶

MediaChannel.setVideoHardMute(true) を実行することで、カメラデバイスからのフレーム取得が停止し、

iOS 端末のカメラインジケーターが消灯します。

また、映像パケットは一切送出されない状態となります。

重要

MediaChannel.setVideoHardMute(Bool enable) は非同期 API のため、利用する際は Task 等を利用した

非同期コンテキスト内で呼び出す必要があります。

Tip

MediaChannel.setVideoHardMute(true) では内部でソフトミュートを有効化した後にハードミュートを有効化します。

そのため、アプリ側でハードミュート前のソフトミュート実行を実装する必要はありません。

ソフトミュートを併用する理由については 黒塗りフレームを送出してから停止する をご確認ください。

CameraVideoCapturer.stop() によるハードミュート¶

CameraVideoCapturer.stop() を実行することで、カメラデバイスからのフレーム取得が停止し、

iOS 端末のカメラインジケーターが消灯します。

また、映像パケットは一切送出されない状態となります。

Tip

CameraVideoCapturer.stop() はコールバック形式の非同期 API です。

Tip

CameraVideoCapturer.stop() によるハードミュート有効化では、停止前に

ソフトミュート を有効にしておくことで受信側の不自然な表示を防ぐことができます。

ソフトミュートを併用する理由については 黒塗りフレームを送出してから停止する をご確認ください。

Sora 接続時にカメラインジケーターを点灯させないで開始する¶

Sora への接続設定 Configuration.initialCameraEnabled に false を指定することで

接続確立時にカメラキャプチャを起動しないで開始します。

このとき、iOS 端末のカメラインジケーターは点灯せず、映像パケットは送出されません (映像ハードミュート相当)。

Configuration.initialCameraEnabled のデフォルト値は true です。

映像が送出されるようにするには MediaChannel.setVideoHardMute(false) を実行するか、

CameraVideoCapturer.start() を実行します。

注釈

Configuration.initialCameraEnabled を false にした場合、接続自体は映像有効となりますが、

接続確立時点でカメラキャプチャが起動しないため、受信側には映像フレームが届きません。

受信側からは通信障害か映像ハードミュート相当かを判別できないため、表示は受信側実装に依存します。

映像のハードミュート無効化¶

映像のハードミュート有効化 で有効化したハードミュートを無効にするには ハードミュートを有効化した方法に合わせて、無効化の方法も選択してください。

MediaChannel.setVideoHardMute(Bool enable) による無効化¶

MediaChannel.setVideoHardMute(false) を実行することで、カメラデバイスからのフレーム取得が再開され、

iOS 端末のカメラインジケーターが点灯します。

また、映像パケットの送出も再開されます。

重要

MediaChannel.setVideoHardMute(Bool enable) は非同期 API のため、利用する際は Task 等を利用した

非同期コンテキスト内で呼び出す必要があります。

Tip

MediaChannel.setVideoHardMute(false) はソフトミュートの無効化処理も含んでいます。

そのため、ソフトミュートの無効化をアプリ側で実装する必要はありません。

ソフトミュートを併用する理由については 黒塗りフレームを送出してから停止する をご確認ください。

CameraVideoCapturer.restart() による無効化¶

CameraVideoCapturer.restart() を実行することで、カメラデバイスからのフレーム取得が再開され、

iOS 端末のカメラインジケーターが点灯します。

また、映像パケットの送出も再開されます。

Tip

CameraVideoCapturer.restart() はコールバック形式の非同期 API です。

Tip

CameraVideoCapturer.stop() によるハードミュート有効化を行い、かつソフトミュートを有効にしていた場合は、

再開後に MediaChannel.setVideoSoftMute(false) も実行してください。

ソフトミュートを併用する理由については 黒塗りフレームを送出してから停止する をご確認ください。

映像のハードミュート機能実装サンプル¶

// setVideoHardMute を使った映像ハードミュートを行う例です。

// 接続や UI のうちハードミュートに不要な部分は省略しています。

import Sora

import UIKit

@MainActor

final class VideoHardMuteViewController: UIViewController {

// 接続完了後に設定される MediaChannel です。

var mediaChannel: MediaChannel?

// カメラのハードミュート状態を保持します。

private var isCameraHardMuted = false

// 映像ハードミュートに利用する MediaChannel.setVideoHardMute(:_) は非同期 API のため

// @IBAction からそのまま await することはできません。このため Task を利用して非同期実行するようにします。

// また、ボタン連打などによる多重実行を防ぐため実行中の Task を保持するねらいもあります。

private var videoHardMuteTask: Task<Void, Never>?

// カメラのハードミュートボタンです。

@IBOutlet weak var cameraHardMuteButton: UIBarButtonItem?

// カメラのハードミュートをトグルします。ボタンにアクションとして紐付けてください。

@IBAction func onCameraHardMuteButton(_ _: UIBarButtonItem) {

// 接続していない場合や映像アップストリームがない場合は何もしません。

guard let mediaChannel = mediaChannel, mediaChannel.senderStream?.hasVideoTrack == true else {

return

}

guard videoHardMuteTask == nil else {

return

}

let nextMuted = !isCameraHardMuted

cameraHardMuteButton?.isEnabled = false

videoHardMuteTask = Task { [weak self] in

// 処理を抜ける際のタスクの無効化とボタンの有効化を確実に行います。

defer {

self?.videoHardMuteTask = nil

self?.cameraHardMuteButton?.isEnabled = true

}

do {

// 映像ハードミュートを非同期で実行します。

try await mediaChannel.setVideoHardMute(nextMuted)

// UI の更新を行います。

guard let self else { return }

self.isCameraHardMuted = nextMuted

self.updateCameraButton(isMuted: nextMuted)

} catch {

// エラー時のハンドリングをします。

_ = error

}

}

}

// ミュート状態に対応したアイコンになるようにボタンを更新します

private func updateCameraButton(isMuted: Bool) {

cameraHardMuteButton?.image = UIImage(systemName: isMuted ? "video.slash.fill" : "video")

}

}

Tip

アプリの実装例については sora-ios-sdk-samples をご確認ください。

映像のソフトミュート¶

通信処理によらないクライアントレイヤーの映像ミュートです。

映像のソフトミュート有効化¶

Sora iOS SDK で映像のソフトミュートを有効にするには MediaChannel.setVideoSoftMute(Bool enable) を利用します。

このメソッドの引数に true を指定することで、映像トラックを無効にします。

このときカメラデバイス由来の映像は配信されず、代わりに黒塗りのフレームを送出する状態となります。

ただしカメラデバイスの入力自体は有効のままのため、iOS 端末のカメラインジケーターは点灯したままになります。

映像のソフトミュート無効化¶

映像のソフトミュート有効化 で有効化したソフトミュートを無効にするには

MediaChannel.setVideoSoftMute(Bool enable) を利用します。

このメソッドの引数に false を指定することで映像トラックが有効になり、カメラデバイスの映像が配信されるようになります。

映像のソフトミュート機能実装サンプル¶

// setVideoSoftMute を使った映像ソフトミュートを行う例です。

// 接続や UI のうちソフトミュートに不要な部分は省略しています。

import Sora

import UIKit

final class VideoSoftMuteViewController: UIViewController {

// 接続完了後に設定される MediaChannel です。

var mediaChannel: MediaChannel?

// カメラのソフトミュート状態を保持します。

private var isCameraSoftMuted = false

// カメラのソフトミュートボタンです。

@IBOutlet weak var cameraSoftMuteButton: UIBarButtonItem?

// カメラのソフトミュートをトグルします。ボタンにアクションとして紐付けてください。

@IBAction func onCameraSoftMuteButton(_ _: UIBarButtonItem) {

// 接続していない場合や映像アップストリームがない場合は何もしません。

guard let mediaChannel = mediaChannel, mediaChannel.senderStream?.hasVideoTrack == true else {

return

}

let nextMuted = !isCameraSoftMuted

// 映像ソフトミュートを実行します。

if let error = mediaChannel.setVideoSoftMute(nextMuted) {

// エラー時のログ出力等を行います。

_ = error

return

}

isCameraSoftMuted = nextMuted

updateCameraButton(isMuted: nextMuted)

}

// ミュート状態に対応したアイコンになるようにボタンを更新します

private func updateCameraButton(isMuted: Bool) {